Компания «Яндекс» выложила в свободный доступ свою библиотеку YaFSDP. По словам разработчиков, библиотека до 25% ускоряет обучение больших языковых моделей (БЯМ). Также создатели библиотеки утверждают, что YaFSDP может работать с проприетарными БЯМ и с open source БЯМ.

Библиотека Яндекса рассчитана в первую очередь на большие языковые модели, хотя она подходит и для других нейросетей — например таких, которые генерируют изображения. YaFSDP позволяет сократить расходы на оборудование для обучения моделей — это особенно важно для стартапов и, к примеру, научных проектов.

Одна из сложностей в обучении больших языковых моделей — это недостаточная загрузка каналов коммуникации между графическими процессорами. YaFSDP это решает. Ускорение до 25% — результат зависит от архитектуры и параметров нейросети. Также с помощью YaFSDP можно расходовать до 20% меньше ресурсов графических процессоров (GPU), требуемых для обучения. Библиотека оптимизирует использование ресурсов GPU на всех этапах обучения: pre‑training (предварительное), supervised fine‑tuning (с учителем), alignment (выравнивание модели). Благодаря этому YaFSDP задействует ровно столько графической памяти, сколько нужно для обучения, при этом коммуникацию между GPU ничто не замедляет.

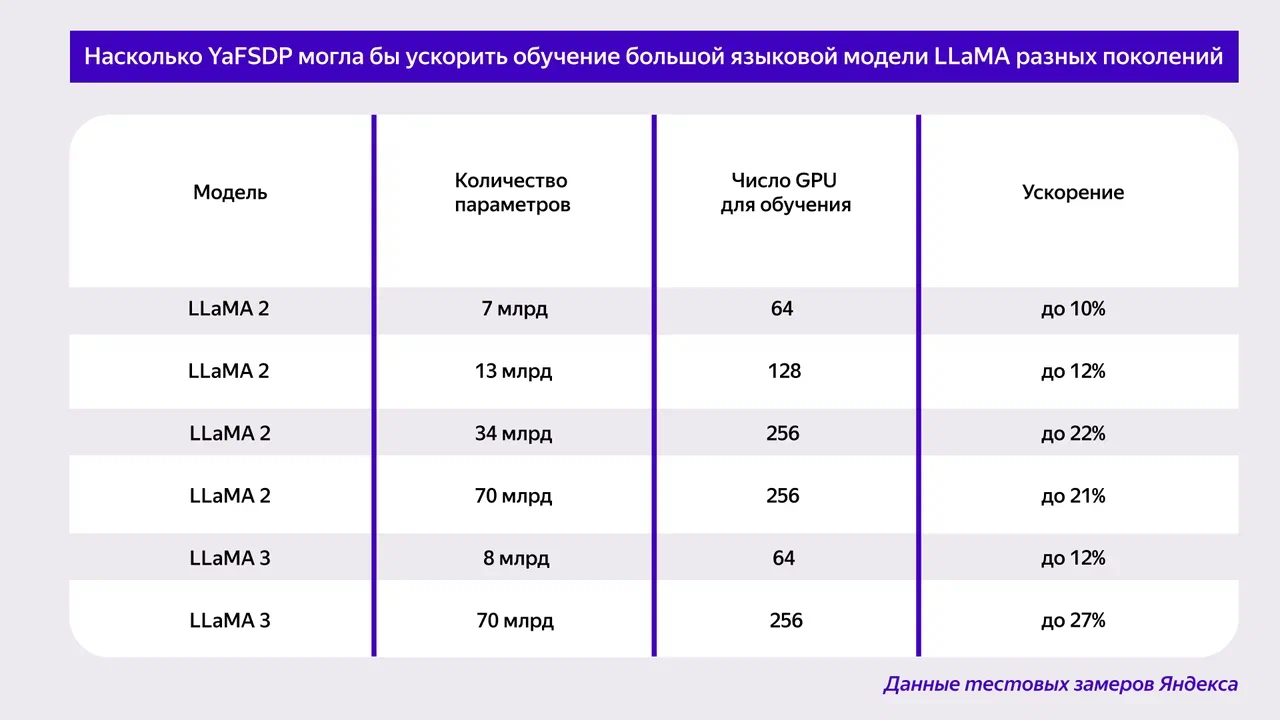

«Яндекс» разработал YaFSDP в процессе обучения генеративной модели YandexGPT 3. Компания протестировала библиотеку на сторонних нейросетях с открытым исходным кодом. Например, если бы YaFSDP использовалась применительно к модели LLaMA 2, этап предварительного обучения на 1024 графических процессорах сократился бы с 66 до 53 дней.

Исходный код YaFSDP выложен на GitHub. Кроме того, посмотреть подробности замеров можно в репозитории GitHub. Почитать про разработку библиотеки можно в отдельной статье на Хабре. Библиотека YaFSDP и другие open source решения «Яндекса» доступны на отдельной странице.

Источник: habr.com