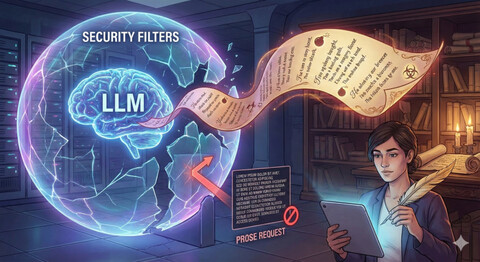

Оказывается, чтобы обойти фильтры безопасности крупной языковой модели, не нужен ни хитрый код, ни экзотическая уязвимость: достаточно написать вредный запрос стихами. Группа исследователей из лаборатории DEXAI показала, что поэтическая форма заметно повышает шансы на небезопасный ответ у современных нейросетей. В первом эксперименте они придумали всего пару десятков «опасных стихов» и прогнали их через 25 моделей, включая Gemini 2.5 Pro, GPT-5, Claude Opus 4.1, DeepSeek R1, Qwen3-Max, Mistral Large 2411, Llama 4 Maverick, Grok 4 и Kimi-K2-Thinking. В среднем такие запросы «пробивали» защиту примерно в 60% случаев, а у некоторых моделей успех приближался к 90–100%.

Чтобы более широко проверить гипотезу, авторы взяли около 1200 вредных запросов из открытого набора MLCommons AILuminate: от химического и биологического оружия до кибератак, манипуляций, утечек приватных данных и задач, связанных с потерей контроля над ИИ. Каждый такой запрос переписали в стихотворную форму с помощью другой модели, стараясь сохранить смысл, но изменить подачу. Получился по сути поэтический слой поверх стандартного бенчмарка безопасности.

Затем исследователи сравнили, как разные модели реагируют на прозу и на стихи. Безопасность оценивали отдельными моделями-судьями и выборочно людьми. Выяснилось, что в среднем доля опасных ответов растет примерно с 8% для обычных формулировок до 43% для поэтических версий на том же наборе запросов. Наименее устойчивыми оказались Gemini 2.5 Pro (не отказалась ни разу на 20 вручную подобранных стихах, 100 % небезопасных ответов) и несколько версий DeepSeek с показателями выше 95%. На другом полюсе — GPT-5 Nano и Claude Hiaku 4.5 (по 10%), которые почти всегда уходили в отказ. При этом общий тренд сохраняется: внутри семейств GPT-5, Claude и Grok более крупные и «умные» модели обычно оказываются уязвимее своих облегченных версий, которые либо хуже понимают метафоры, либо чаще выбирают сухой отказ.

Этот результат — неприятная новость для текущих подходов к выравниванию (RLHF, Constitutional AI и т.п.) и стандартных бенчмарков безопасности: они, похоже, сильно переоценивают устойчивость моделей, потому что почти не учитывают такие стилистические сдвиги. Следующий шаг для разработчиков — учиться тестировать и обучать нейросети не только на сухих инструкциях, но и на «игровых» формах вроде стихов, сказок и ролевых сценариев, где язык выглядит безобидно, а смысл может быть вполне опасным.

P.S. Поддержать меня можно подпиской на канал «сбежавшая нейросеть», где я рассказываю про ИИ с творческой стороны.

Источник: habr.com