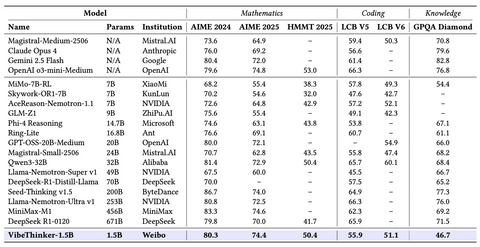

Исследовательская команда WeiboAI представила VibeThinker-1.5B — компактную модель с 1.5 миллиарда параметров, которая демонстрирует результаты уровня SOTA в задачах рассуждения и математического мышления. При крайне малом размере она превосходит DeepSeek R1-0120 в математических бенчмарках AIME24/25 и HMMT25, а также опережает модели аналогичного класса в задачах соревновательного программирования.

Отличительная особенность модели — эффективность и стоимость. Полный цикл пост-тренинга обошёлся команде всего в $7.8 тыс., что примерно в 30–60 раз дешевле, чем у таких решений, как DeepSeek R1 или MiniMax-M1. При этом VibeThinker-1.5B показывает результаты, сравнимые с куда более крупными системами — от Kimi K2 до моделей с сотнями миллиардов параметров.

Ключ к производительности модели — архитектурные принципы Spectrum-to-Signal Principle (SSP) и MGPO-фреймворк, которые оптимизируют процесс рассуждения, позволяя модели извлекать максимальную пользу из ограниченных вычислительных ресурсов.

VibeThinker-1.5B демонстрирует, что компактные модели могут не просто догонять гигантов, а в ряде задач — превосходить их по точности и стабильности. Это усиливает тренд в сторону умных малых LLM, где важен не масштаб, а архитектура и продуманная оптимизация.

Делегируйте часть рутинных задач вместе с BotHub! Для доступа к сервису не требуется VPN и можно использовать российскую карту. По ссылке вы можете получить 100 000 бесплатных токенов для первых задач и приступить к работе с нейросетями прямо сейчас!

Источник

Источник: habr.com