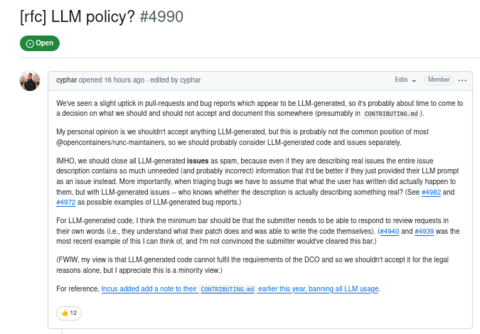

Команда открытого проекта runc (это инструмент командной строки для создания и запуска контейнеров в Linux в соответствии со спецификацией OCI) столкнулась с ростом pull-request и отчётов об ошибках, сгенерированных ИИ.

Вероятно, пришло время принять решение о том, что мы должны и чего не должны принимать из-за активности ИИ, и задокументировать эти моменты, пояснил мейнтейнер команды проекта opencontainers (Open Container Initiative) Алекса Сарай (Aleksa Sarai).

По мнению разработчика:

команда не должна принимать ничего, сгенерированного ИИ или им следует рассматривать сгенерированный ИИ код и issue отдельно;

как вариант, нужно закрывать все сгенерированные ИИ issue как спам, потому что, даже если они описывают реальные issue, всё их описание содержит так много ненужной (и, вероятно, неверной) информации, что было бы лучше, если бы они просто предоставили свой промпт к ИИ в качестве issue;

что еще важнее, при рассмотрении issue разработчики должны предполагать, что то, что написал пользователь, действительно произошло с ним, но в случае с проблемами, сгенерированными ИИ, — кто знает, действительно ли описание описывает что-то реальное? (cм. #4982 и #4972 в качестве возможных примеров сгенерированных ИИ отчётов об ошибках);

что касается сгенерированного ИИ кода, минимальным требованием должно быть то, что отправитель должен быть в состоянии ответить на review request своими собственными словами.

По мнению Алекса Сарай использование LLM вполне допустимо для перевода с иностранного языка на английский, поиска и исправления грамматических ошибок и опечаток, автозаполнения тривиальных текстов и кода (например, if err != nil { return nil, err }).

Примечательно, что в начале ноября японское сообщество центра поддержки пользователей Support.mozilla.org (SUMO) объявило о закрытии из-за внедрения Mozilla бота SumoBot для машинного перевода и перезаписи новыми сгенерированными данными сотен публикаций с переводами людей-экспертов.

В октябре 2025 года Управляющий совет проекта Fedora после двухнедельных дискуссий утвердил правила, регламентирующие применение ИИ‑инструментов при разработке дистрибутива Fedora Linux. В проекте Fedora ИИ‑инструменты рассматриваются как потенциальная возможность сделать платформу лучше. У сообщества при этом имеются опасения, связанные с конфиденциальностью, безопасностью, этикой и качеством. В Fedora предложено не запрещать использование ИИ‑ассистентов при обязательном человеческом контроле за результатом их работы и несении разработчиком ответственности за код.

В середине октября 2025 года автор curl Даниэль Стенберг сообщил, что ИИ-инструменты для проверки кода Almanax, Corgea, ZeroPath, Gecko и Amplify позволили одному исследователю по ИБ Джошуа Роджерсу выявить и обнаружить сразу 50 ошибок и багов в открытой утилите. Оказывается, проблема была в разработчиках, а не в технологиях. В прошлом месяце проект curl получил десятки сообщений о потенциальных проблемах от Джошуа Роджерса, исследователя безопасности из Польши. Роджерс выявил множество ошибок и уязвимостей с помощью различных инструментов сканирования с помощью искусственного интеллекта. И его отчёты были не только достоверными, но и оценены по достоинству. Стенберг отметил, что «на самом деле, это действительно потрясающие находки».

Примечательно, что ранее Стенберг объявил, что его открытый проект curl перестанет изучать отчёты об уязвимостях через платформу HackerOne, полученные с помощью ИИ-систем. По заверению Стенберга, подобные массовые сообщения об уязвимостях от систем на базе ИИ перегружают команду проекта. Для проверки ИИ-отчётов необходимо время, которое несравнимо с тем временем, что тратится для создания подобных отчётов при помощи ИИ.

Источник: habr.com