Perplexity представила научную работу, в которой описала технологию запуска моделей с триллионом параметров на обычных кластерах AWS. Раньше для этого требовались специализированные GPU-сети с поддержкой GPUDirect Async, но инженеры компании нашли способ обойти ограничение.

Они создали собственные ядра параллелизма, где центральный процессор координирует обмен данными между видеокартами. Токены упаковываются и передаются через RDMA-соединения, что позволяет совмещать вычисления и пересылку данных почти без потерь производительности.

Результат впечатляет: тесты показали, что многосерверная система AWS с новой архитектурой работает почти так же быстро, как единый GPU-кластер. Это делает платформу AWS EFA пригодной для инференса гигантских моделей вроде DeepSeek V3 и Kimi K2 без необходимости строить собственные дата-центры.

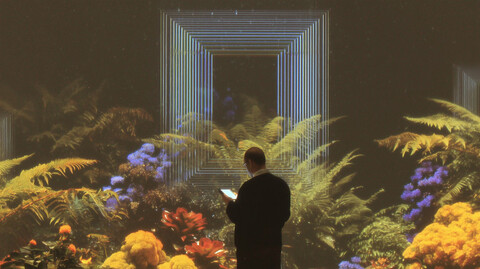

Если раньше тренировать триллионную модель могли только OpenAI или Anthropic, то теперь подобные эксперименты становятся возможны и для небольших лабораторий. По сути, Perplexity открыла дверь в эпоху, где масштаб больше не требует миллиардных инвестиций в инфраструктуру.

Делегируйте часть рутинных задач вместе с BotHub! Для доступа к сервису не требуется VPN и можно использовать российскую карту. По ссылке вы можете получить 100 000 бесплатных токенов для первых задач и приступить к работе с нейросетями прямо сейчас!

Источник

Источник: habr.com