Google объявила о доступности в ближайшие недели ИИ-ускорителя седьмого поколения TPU v7 Ironwood, специально разработанного для самых требовательных рабочих нагрузок: от обучения крупномасштабных моделей и сложного обучения с подкреплением (RL) до высокопроизводительного ИИ-инференса и обслуживания моделей с малой задержкой.

Google отметила, что современные передовые ИИ-модели, включая Gemini, Veo, Imagen от Google и Claude от Anthropic, обучаются и работают на TPU. Многие компании смещают акцент с обучения этих моделей на обеспечение эффективного и отзывчивого взаимодействия с ними. Постоянно меняющаяся архитектура моделей, рост агентных рабочих процессов и практически экспоненциальный рост спроса на вычисления определяют новую эру инференса.

В частности, ИИ-агенты, требующие оркестрации и тесной координации между универсальными вычислениями и ускорением машинного обучения, создают новые возможности для разработки специализированных кремниевых процессоров и вертикально оптимизированных системных архитектур. TPU Ironwood призван обеспечить новые возможности для инференса и агентных рабочих нагрузок.

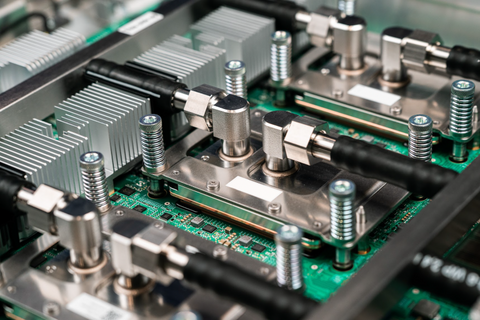

Источник изображений: Google

TPU Ironwood был представлен в апреле этого года. По данным Google, он обеспечивает десятикратное увеличение пиковой производительности по сравнению с TPU v5p и более чем четырёхкратное увеличение производительности на чип как для обучения, так и для инференса по сравнению с TPU v6e (Trillium), что делает Ironwood самым мощным и энергоэффективным специализированным кристаллом компании на сегодняшний день.

Google сообщила, что на базе Ironwood можно создавать кластеры, включающие до 9216 чипов (42,5 Эфлопс в FP8), объединённых Inter-Chip Interconnect (ICI) со скоростью 9,6 Тбит/с с доступом к 1,77 Пбайт общей памяти HBM, преодолевая узкие места для данных даже самых требовательных моделей. Компания отметила, что в таком масштабе сервисы требуют бесперебойной доступности. Её гарантирует технология оптической коммутации (OCS), которая реализуется как динамическая реконфигурируемая инфраструктура. А если клиенту требуется больше мощности, Ironwood масштабируется в кластеры из сотен тысяч TPU.

Своим клиентам, пользующимся решениями на TPU, компания предлагает возможности Cluster Director в Google Kubernetes Engine. Это включает в себя расширенные возможности обслуживания и понимания топологии для интеллектуального планирования и создания высокоустойчивых кластеров.

Для предобучения и постобучения компания предлагает новые улучшения MaxText, высокопроизводительного фреймворка LLM с открытым исходным кодом, которые упрощают внедрение новейших методов оптимизации обучения и обучения с подкреплением, таких как контролируемая тонкая настройка (SFT) и оптимизация политики генеративного подкрепления (GRPO) — алгоритм обучения с подкреплением (RL). Также улучшена поддержка vLLM, что позволит с минимальными усилиями перенести инференес с GPU на TPU. А GKE Inference Gateway позволит снизить задержку выдачи первого токена (TTFT).

Источник: servernews.ru