OpenAI передаёт больше инструментов контроля безопасности непосредственно в руки разработчиков ИИ, запуская исследовательскую версию своих новых «защитных»(safeguard) моделей.Новое семейство моделей с открытыми весами gpt-oss-safeguard разработано специально для гибкой настройки и адаптации систем классификации контента под конкретные задачи и требования пользователей.

В линейку входят две модели — gpt-oss-safeguard-120b и более компактная gpt-oss-safeguard-20b. Обе модели представляют собой дообученные версии существующего семейства gpt-oss и будут доступны под разрешительной лицензией Apache 2.0. Это означает, что любые организации смогут свободно использовать, модифицировать и развёртывать их на своих условиях.

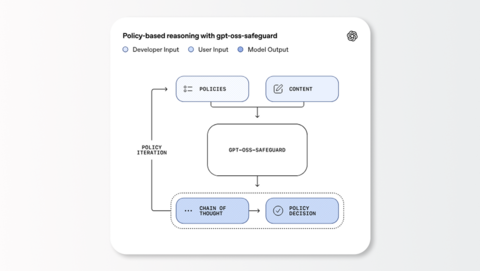

Главное отличие состоит не только в открытой лицензии, но и в самом подходе. Вместо опоры на жёстко прописанный набор правил, модель gpt-oss-safeguard использует свои способности рассуждения для интерпретации политики разработчика на этапе вывода. Это означает, что разработчики, использующие новую модель OpenAI, могут настраивать собственную систему безопасности для классификации как отдельных запросов пользователя, так и целых историй чата.

Разработчик, а не поставщик модели, принимает окончательное решение о наборе правил и может адаптировать его под конкретный сценарий использования.

У этого подхода есть несколько очевидных преимуществ:

Прозрачность. Модели используют механизм «цепочки рассуждений» (chain of thought), благодаря чему разработчик действительно может заглянуть «под капот» и увидеть логику, по которой модель принимает решение о классификации. Это значительный шаг вперёд по сравнению с типичными классификаторами-«чёрными ящиками».

Гибкость. Поскольку политика безопасности не жёстко зашита в новую модель OpenAI, разработчики могут оперативно пересматривать и обновлять свои правила без необходимости полного цикла переобучения. В OpenAI отмечают, что изначально эта система создавалась для внутренних команд компании и представляет собой гораздо более гибкий способ управления безопасностью, чем традиционные классификаторы, которые лишь косвенно пытаются угадать намерения, заложенные в политике.

Вместо того чтобы полагаться на универсальный слой безопасности от владельца платформы, разработчики, использующие открытые модели ИИ, теперь могут создавать и внедрять собственные, специализированные стандарты безопасности.

Хотя на момент публикации модели ещё не запущены в открытый доступ, разработчики смогут получить к ним доступ на платформе Hugging Face, где будут размещены открытые версии моделей безопасности ИИ от OpenAI.

Источник: AINews

Чтобы не пропустить анонс новых материалов подпишитесь на «Голос Технократии» — мы регулярно рассказываем о новостях про AI, LLM и RAG, а также делимся полезными мастридами и актуальными событиями.

Источник: habr.com