Исследователи Ant Group опубликовали техническое исследование модели Ring-1T — одной из крупнейших и самых устойчивых reasoning-систем в мире. Она содержит 1 триллион параметров, но при генерации использует только 50 миллиардов активных.

Ring-1T уже достигает уровня IMO 2025 Silver, что означает способность решать олимпиадные задачи и логические цепочки, требующие многозвенной аргументации.

Главное достижение — устойчивость при долгом мышлении. Большинство больших моделей теряют фокус после 30–40 шагов рассуждения, но Ring-1T стабильно работает на сотнях итераций.

Это стало возможным благодаря трём инновациям:

IcePop — система, стабилизирующая градиенты при длинных рассуждениях, чтобы модель не сходила с ума от перегрева контекста.

C3PO++ — механизм, оптимизирующий использование GPU и минимизирующий пустые вычисления.

ASystem — новый планировщик синхронизации, делающий RL-обучение более предсказуемым и устойчивым.

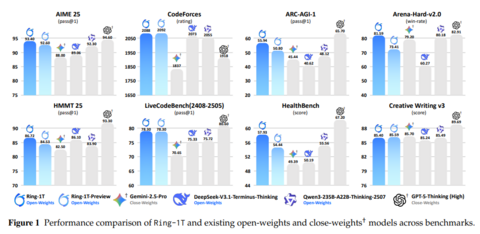

Результаты на тестах: 55.94 на ARC AGI 1 и 2088 на CodeForces, что уже выше большинства reasoning-LLM коммерческого класса.

Делегируйте часть рутинных задач вместе с BotHub! Для доступа к сервису не требуется VPN и можно использовать российскую карту. По ссылке вы можете получить 100 000 бесплатных токенов для первых задач и приступить к работе с нейросетями прямо сейчас!

Источник

Источник: habr.com