PyTorch снова делает шаг вперёд в инфраструктуре AI. Команда анонсировала Monarch, систему распределённых вычислений, которая позволяет управлять тысячами графических процессоров из одного простого Python-скрипта.

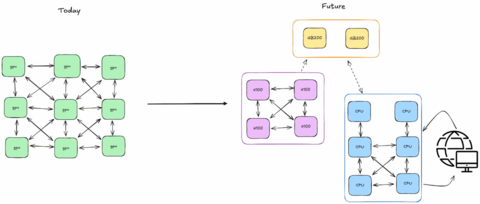

До сих пор разработчики пользовались SPMD-подходом, где каждый узел в кластере выполняет одинаковый код независимо, но Monarch ломает этот принцип. Теперь можно писать одну управляющую программу, а фреймворк сам распределяет вычисления и синхронизацию между узлами.

Monarch вводит концепцию многомерных вычислительных сеток (meshes) — структур, в которых процессы и акторы могут напрямую взаимодействовать между собой, передавая данные GPU без участия CPU, через RDMA. Это сильно сокращает накладные расходы и ускоряет задачи вроде обучения RL, fine-tuning или многомодального анализа.

Бонус — полная совместимость с привычным Python. Можно использовать Jupyter Notebook и дебажить всё в реальном времени. Система поддерживает динамическое масштабирование, отказоустойчивость и понятную отладку ошибок.

Фреймворк уже встроен в TorchForge, VERL и Lightning AI, что делает его потенциальным стандартом для новой волны распределённого обучения. Фактически, Monarch превращает кластер в единый мозг, управляемый из одного окна. Следим за новостями дальше!

Делегируйте часть рутинных задач вместе с BotHub! Для доступа к сервису не требуется VPN и можно использовать российскую карту. По ссылке вы можете получить 100 000 бесплатных токенов для первых задач и приступить к работе с нейросетями прямо сейчас!

Источник

Источник: habr.com