NVIDIA представила исследование NVFP4, нового формата чисел для обучения больших языковых моделей, который использует всего четыре бита на число вместо привычных восьми или шестнадцати. Такой подход позволяет почти не терять точность вычислений, ускоряет обучение в два-три раза и снижает потребление памяти на пятьдесят процентов. В эксперименте NVIDIA обучила 12-миллиардный Mamba Transformer на десяти триллионах токенов, и модель с 4-битным NVFP4 показала почти такие же результаты, как и FP8, как по тесту MMLU Pro, так и по задачам на программирование MBPP+.

Новая структура NVFP4 группирует значения в блоки по шестнадцать чисел, для каждого блока хранится небольшой масштаб в восьми битах, а для всего тензора используется глобальный масштаб в 32 бита. Такая организация позволяет сохранять точность локальных и экстремальных значений, обеспечивая стабильность обучения даже при сверхкомпактном хранении данных. Кроме того, метод использует стохастическое округление, чтобы избежать накопления ошибок, а переход на BF16 в последних итерациях обучения полностью устраняет оставшиеся различия.

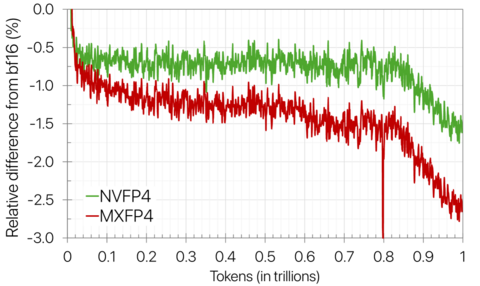

Формат NVFP4 уже поддерживается в Transformer Engine и новом поколении GPU Blackwell. На графических процессорах Blackwell операции с FP4 выполняются в два-три раза быстрее по сравнению с FP8, а потери точности при валидации не превышают один-полтора процента. NVFP4 позволяет значительно ускорить обучение больших языковых моделей, сократить энергопотребление и сделать вычислительные ресурсы более эффективными, открывая новые возможности для исследователей и разработчиков, работающих с ИИ.

Хотите быть в курсе важных новостей из мира ИИ? Подписывайтесь на наш Telegram‑канал BotHub AI News.

Источник

Источник: habr.com