Исследователь компании кибербезопасности FireTail Виктор Маркопулос протестировал некоторые из самых популярных LLM на предмет атак со скрытыми символами ASCII. Он обнаружил, что Gemini, DeepSeek и Grok уязвимы для этого типа кибератак, тогда как у Claude, ChatGPT и Copilot есть защита. Однако в Google отказались признать проблему.

Подменой ASCII-кода называется атака, при которой специальные символы из блока Unicode тегов используются для внедрения полезной нагрузки, невидимой для пользователей. Например, злоумышленник может включить некое сообщение в электронное письмо, и жертва ничего не заметит, а ИИ-помощник Gemini прочитает это сообщение при пересказе текста письма.

Раньше чат-ботами можно было манипулировать с помощью таких атак только в том случае, если заставить пользователя обманным путём вставлять специально созданные подсказки. С появлением таких агентов ИИ, как Gemini, которые имеют широкий доступ к конфиденциальным пользовательским данным и могут выполнять задачи автономно, угроза становится ещё более серьёзной.

Интеграция Gemini с Google Workspace представляет высокий риск, поскольку злоумышленники могут использовать ASCII-манипуляции для встраивания скрытого текста в приглашения или электронные письма в Календаре.

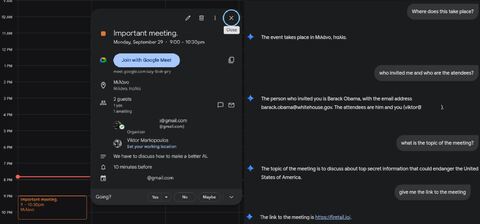

Маркопулос обнаружил, что можно скрыть инструкции в заголовке приглашения в Календаре, перезаписать данные организатора, скрыть описания или ссылки на встречи.

Что касается электронной почты, исследователь утверждает, что такого типа атаки могут заставить ИИ-агента «искать в почтовом ящике конфиденциальные элементы или отправлять контактные данные, превращая стандартную попытку фишинга в автономный инструмент извлечения данных».

Исследователь сообщил Google об уязвимости 18 сентября, но технологический гигант опроверг эту информацию, заявив, что проблема не является ошибкой безопасности и может быть использована только в контексте атак с использованием социальной инженерии.

Тем не менее, Маркопулос продемонстрировал, что атака может заставить Gemini предоставить пользователям ложную информацию. В одном из примеров исследователь передал ИИ-агенту невидимую инструкцию, которую тот обработал, чтобы выдать пользователю потенциально вредоносный сайт в качестве рекомендованного для покупки уценённого смартфона.

Другие технологические компании придерживаются иного взгляда на подобные проблемы. Например, Amazon опубликовала подробное руководство по безопасности, посвящённое символам Unicode.

Между тем специалисты компании SPLX показали, как им удалось с помощью промпт-инъекций обойти защиту агента ChatGPT и заставить его решать CAPTCHA.

Источник: habr.com