Google представила LiteRT-LM — фреймворк, который позволяет запускать большие языковые модели локально, без подключения к интернету. Именно он лежит в основе Gemini Nano в Chrome, Chromebook Plus и Pixel Watch. • Работая над LiteRT-LM , Google сделали быстрого, дешевого, конфиденциального и самое главное — офлайн агента.

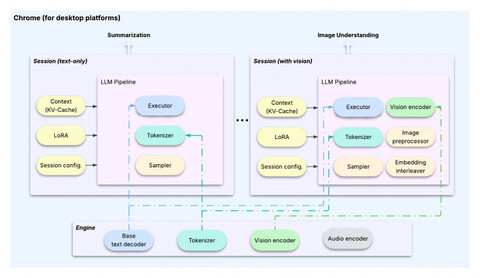

Как фреймворк организует on-device LLM-пайплайны для различных задач

LiteRT-LM делится на Engine (ядро) auto engine = Engine::Create(«gemini_nano.tflite»); auto tokenizer = engine->GetTokenizer(); auto base_decoder = engine->GetTextDecoder();Session (отдельная задача, например обработка картинки)

auto session = engine->CreateSession(); session->LoadLoRA(«summarizer.lora»); session->SetKVCacheEnabled(true);

std::string result = session->Run(«Summarize this text: …»);Следует подметить следующие оптимизации: Context Switching , Session Cloning и Copy-on-Write KV-Cache Сам фреймворк, он же полноценный стек для on-device LLM уже работает на Android, Linux, macOS, Windows и даже Raspberry Pi , поддерживает ускорение с помощью CPU, GPU и NPU. Можно даже интегрировать LiteRT-LM в свои проекты, потому что все это С++ и относительно прозрачный API

Теперь разработчики могут собирать приложения с языковыми моделями, которые работают автономно — хоть в браузере, хоть на Raspberry Pi.

🔗 LiteRT HuggingFace community

🔗 GitHub

📌 70+ ИИ — моделей без vpn и ограничений

Источник: habr.com