Вчера GLM выпустили очередное обновление своей флагманской модели.

Что завезли:

Контекстное окно выросло до 200k токенов.

Обещают, что кодинг стал быстрее и точнее. По крайней мере в бенчмарках.

Больше «агентности» — модель умнее пользуется инструментами, анализирует и выводы делает без растраты лишних токенов.

GLM-4.6 бьет по метрикам DeepSeek-V3.1-Terminus и даже Claude Sonnet 4.

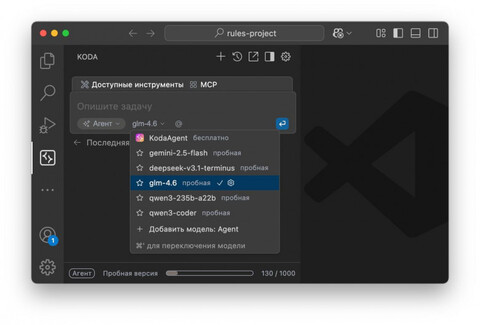

Подробнее про релиз можно прочитать тут. А попробовать саму модель можно абсолютно бесплатно уже сейчас в VS Code. Для этого просто установите Koda, выполните вход через GitHub аккаунт и пользуйтесь!

Также на днях обновился DeepSeek до версии 3.1-terminus. Её мы тоже уже добавили в список доступных моделей. Пользуйтесь 🙂

Источник: habr.com