Cloudflare представила новое дополнение к своему сервису robots.txt — политику Content Signals Policy. Эта бесплатная функция помогает владельцам сайтов лучше контролировать, как компании, работающие с искусственным интеллектом, получают доступ к их контенту и используют его.

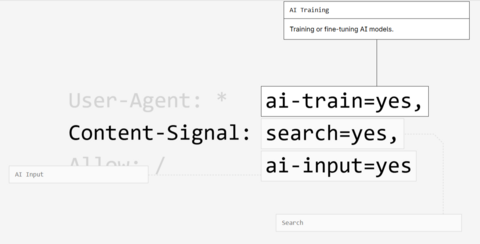

Стандартный файл robots.txt уже позволяет сайтам указывать, какие поисковые роботы могут собирать данные и какие разделы сайта должны оставаться закрытыми. Новая политика Cloudflare вводит дополнительный уровень управления: теперь можно задать, как именно разрешается использовать полученный контент — только для поиска, для поиска и обучения ИИ или вообще никак.

«Интернет не может ждать, пока оригинальный контент используется другими компаниями для получения прибыли. Мы помогаем владельцам сайтов указывать, каким компаниям разрешено использовать их контент», — рассказал Мэтью Принс, соучредитель и генеральный директор Cloudflare.

В июне Принс заявлял, что опасается за будущее издательств на фоне развития искусственного интеллекта. По его словам, доверие пользователей к ИИ растёт, и это приводит к тому, что они всё реже обращаются к первоисточникам. Поскольку число переходов с поисковиков на сайты с оригинальным контентом постоянно сокращается, многие издатели сталкиваются с необходимостью кардинального изменения своих бизнес-моделей или даже ухода с рынка.

Принс отметил, что если десять лет назад на две проиндексированные Google страницы приходился один переход со страницы поисковой выдачи на сайт издателя, то сейчас соотношение кардинально изменилось. Для Google оно составляет 8 страниц к 1 переходу (8:1), для OpenAI — 1500:1, Anthropic — 60000:1. Для сравнения, ещё шесть лет назад соотношения были следующими: Google — 6:1, OpenAI — 250:1, Anthropic — 6000:1.

Источник: habr.com