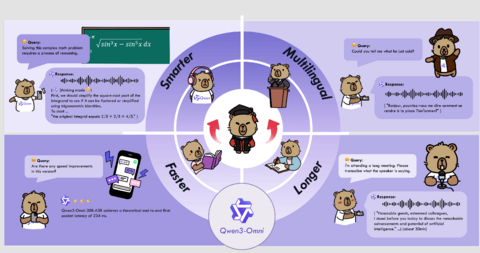

Qwen3-Omni — это изначально многоязычная омни-модель с поддержкой end-to-end. Она обрабатывает текст, изображения, аудио и видео и выдает потоковые ответы в реальном времени — как в виде текста, так и в живой речи. Мы добавили ряд улучшений для повышения производительности и эффективности.

Ключевые особенности:

Изначально омни-модальное предобучение: Qwen3-Omni — это нативная end-to-end многоязычная омни-модель, которая не уступает по производительности специализированным моделям для отдельных модальностей.

Высокая производительность: Qwen3-Omni достигает SOTA-результатов на 32 бенчмарках и занимает первое место в 22 из 36 аудио- и аудиовизуальных тестов, обгоняя сильные закрытые модели, такие как Gemini-2.5-Pro, Seed-ASR и GPT-4o-Transcribe.

Многоязычная поддержка: Qwen3-Omni понимает текст на 119 языках, речь — на 19 языках и может генерировать речь на 10 языках.

Быстрый отклик: задержка в аудиосценариях может быть всего 211 мс, а в аудио-видео сценариях — от 507 мс.

Глубокое понимание: поддерживается анализ аудио продолжительностью до 30 минут.

Персонализация: Qwen3-Omni можно адаптировать с помощью системных промптов, меняя стиль ответов, личность и поведенческие характеристики.

Вызов инструментов: Qwen3-Omni поддерживает вызов функций, что позволяет бесшовно интегрироваться с внешними сервисами и инструментами.

Open source универсальный аудиокапшенер: Qwen3-Omni-30B-A3B-Captioner — это подробная и устойчивая к галлюцинациям модель для генерации описаний аудио, которая закрывает важный пробел в Open source сообществе.

Архитектура

Qwen3-Omni построена на архитектуре Thinker-Talker. Thinker отвечает за генерацию текста, а Talker — за потоковую генерацию речевых токенов, получая высокоуровневые представления напрямую от Thinker. Для достижения сверхнизкой задержки Talker авторегрессионно предсказывает многокодовую последовательность. На каждом шаге декодирования модуль MTP формирует остаточные кодбуки для текущего кадра, после чего рендерер Code2Wav постепенно синтезирует соответствующую звуковую волну, что позволяет генерировать речь покадрово в режиме реального времени.

Инновационный дизайн архитектуры

AuT: аудиоэнкодер использует AuT, обученный на 20 миллионах часов аудиоданных, что обеспечивает крайне сильные универсальные представления для работы со звуком.

MoE: и Thinker, и Talker используют архитектуру MoE, что дает поддержку высокой параллельности и быстрой инференции.

Multi-Codebook: Talker реализует многокодовую авторегрессионную схему: на каждом шаге он генерирует один кодек-кадр, а модуль MTP достраивает оставшиеся остаточные кодбуки.

Отсутствие деградации между модальностями

Совмещение одномодальных и кросс-модальных данных на ранних этапах предобучения текста позволяет достичь равенства по всем модальностям — то есть не происходит ухудшения производительности в отдельных модальностях, при этом значительно усиливаются кросс-модальные возможности.

Отличный диалог и следование инструкциям в устной форме

Qwen3-Omni достигает уровня Gemini-2.5-Pro в задачах распознавания речи и выполнения инструкций.

Реальное время для аудио и аудиовизуального взаимодействия

Существенное сокращение задержек по всей цепочке — от энкодеров до Thinker, Talker и Code2Wav — делает возможной полностью потоковую генерацию, начиная уже с первого кодек-кадра.

Производительность

Мы провели всестороннюю оценку Qwen3-Omni, которая показывает результаты на уровне одномодальных моделей аналогичного размера из серии Qwen и особенно выделяется в аудиозадачах. В 36 аудио- и аудиовизуальных бенчмарках Qwen3-Omni достигает лучших в Open source результатов в 32 тестах и занимает первое место в 22 из них, обгоняя сильные закрытые модели, такие как Gemini-2.5-Pro, Seed-ASR и GPT-4o-Transcribe.

Русскоязычное сообщество про AI в разработке

Друзья! Эту статью подготовила команда ТГК «AI for Devs» — канала, где мы рассказываем про AI-ассистентов, плагины для IDE, делимся практическими кейсами и свежими новостями из мира ИИ. Подписывайтесь, чтобы быть в курсе и ничего не упустить!

Источники

GitHub

Демо на Hugging Face

Статья анонс

Источник: habr.com