Долгое время мощь ИИ-моделей напрямую связывалась с их размером: число параметров росло до сотен миллиардов и даже триллионов. Но слишком большие модели создают очевидные проблемы для компаний: отсутствие контроля над системой, зависимость от сторонних облаков и непредсказуемые расходы.

На фоне этого набирает обороты противоположный тренд — малые языковые модели (SLM), которые можно запускать прямо на ПК и смартфонах.

Последний и самый яркий пример — Meta* MobileLLM-R1, семейство моделей с менее чем миллиардом параметров, специализирующихся на решении задач с рассуждениями. Их появление подтверждает общий поворот индустрии от принципа «больше значит лучше» к ставке на компактные и эффективные модели.

MobileLLM-R1 от Meta* — это семейство reasoning-моделей с размерами 140M, 360M и 950M параметров, специально предназначенных для математики, программирования и научных задач (они не подходят для общих чат-приложений).

Эффективность достигается за счет архитектурных решений, заложенных ещё в оригинальной линейке MobileLLM, оптимизированной для моделей до 1 млрд параметров. Например, используется архитектура deep-and-thin (глубже слоев при меньших эмбеддингах) и прием grouped-query attention (разделяемые веса внимания для сокращения числа параметров). В сочетании с очень эффективным процессом обучения это позволяет запускать сложные вычисления даже на ограниченных устройствах.

Для обучения использовалось около 5 трлн токенов (для сравнения: у других моделей сопоставимого размера — десятки триллионов), включая дистиллированные данные из Llama-3.1-8B-Instruct, что позволило перенести развитые способности к рассуждению без гигантских затрат на обучение.

Производительность MobileLLM-R1

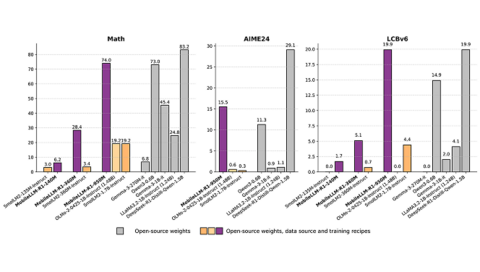

Модель на 950M параметров немного превосходит Alibaba Qwen3-0.6B на бенчмарке MATH (74,0 против 73,0) и уверенно лидирует на тесте LiveCodeBench (19,9 против 14,9). Это делает её удобной для сценариев, где нужна надёжная офлайн-логика, например встроенные ассистенты кодинга в девелоперских инструментах.

Однако есть важный нюанс: модель выпущена под лицензией Meta* FAIR Non-Commercial, которая строго запрещает любое коммерческое использование модели или её выводов. Для компаний это значит, что MobileLLM-R1 — скорее мощный исследовательский эталон или внутренний инструмент, чем готовый к монетизации продукт. (На странице Hugging Face указано: «MobileLLM-R1 сейчас под FAIR NC», то есть условия могут измениться в будущем.)

Конкуренция на рынке малых языковых моделей

Хотя MobileLLM-R1 демонстрирует топовую производительность, в сегменте SLM уже есть коммерчески доступные альтернативы под разные задачи.

Google Gemma 3 270M — сверхэкономичная модель на 270 млн параметров, ориентированная на минимальное энергопотребление. Внутренние тесты показали: 25 диалогов тратят меньше 1% заряда телефона. Благодаря либеральной лицензии она подходит компаниям, которым нужны небольшие специализированные модели для задач вроде модерации контента или проверки на соответствие требованиям.

Alibaba Qwen3-0.6B — сильный претендент для бизнеса, которому важны готовые reasoning-возможности без ограничений по лицензии. С Apache-2.0 и сравнимой с MobileLLM-R1 производительностью, модель является практичным коммерческим решением.

Nvidia Nemotron-Nano предлагает уникальные «регуляторы», позволяя включать или выключать рассуждение командами и задавать «бюджет на мышление» для баланса скорости и точности.

Liquid AI делает ставку на мультимодальность на устройствах: их модели работают с текстом и изображениями, при этом компания предлагает SDK для быстрой интеграции. Кроме того, они экспериментируют с «жидкими нейросетями» — новой архитектурой, которая обещает радикально сократить вычислительные и ресурсные затраты на запуск ИИ.

Индустриальный сдвиг в сторону SLM — это ответ на боли бизнеса. Использование больших облачных моделей ведет к непредсказуемым расходам и оставляет компании без контроля над обновлениями или снятием поддержки. Как отметил CEO Liquid AI Рамин Хасани в интервью VentureBeat:

«Компании понимают, что малые модели дают предсказуемость. Вместо оплаты за каждый API-запрос можно один раз лицензировать модель и использовать её бесконечно локально».

Это также решает вопросы приватности и надёжности: локальная обработка чувствительных данных повышает соответствие регуляциям и обеспечивает работу приложений без постоянного подключения к интернету. Хасани видит в этом «триллионный рынок малых моделей к 2035 году».

Появление таких SLM открывает новую архитектурную стратегию: вместо одной гигантской универсальной модели компании могут разворачивать «флот специалистов». Этот подход напоминает переход софтверной индустрии от монолитов к микросервисам: сложная задача разбивается на набор мелких подзадач, каждая из которых решается тонко-настроенной SLM.

Эта стратегия ближе к развитию агентных приложений, где задачи делятся между специализированными агентами. Как отмечают исследователи Nvidia, доминирование LLM «избыточно и не соответствует требованиям большинства агентных сценариев». Напротив, подход с «флотом» снижает затраты, ускоряет работу и обеспечивает прозрачность при сбоях.

Роль больших моделей

Это не значит, что крупные модели теряют актуальность. Наоборот, они получают новую роль. Как объясняет исследователь Андрей Карпатый, современные гиганты достаточно мощны, чтобы «перепрофилировать и упаковывать обучающие данные в синтетические форматы», из которых затем дистиллируются чистые reasoning-навыки для малых и более эффективных моделей.

Так возникает симбиоз: каждое поколение больших моделей помогает создавать идеальные датасеты для следующего поколения быстрых и компактных SLM, что делает развитие ИИ более устойчивым.

Источник: VentureBeat*На территории России запрещена деятельность компании Meta и принадлежащих ей Facebook и Instagram.

Чтобы не пропустить анонс новых материалов подпишитесь на «Голос Технократии» — мы регулярно рассказываем о новостях про AI, LLM и RAG, а также делимся полезными мастридами и актуальными событиями.

Источник: habr.com