Чат‑боты за последний год стали распространять ложную информацию вдвое интенсивнее, выяснили исследователи NewsGuard. При этом чат‑боты стали реже отказываться от ответов на запросы, отмечается в исследовании.

Специалисты NewsGuard изучают 10 наиболее популярных ИИ‑инструментов. Чат‑ботам дают промпты на спорные темы, по которым чаще всего распространяется ложная информация — о политике, здравоохранении, международных отношениях, а также о компаниях и брендах. Согласно исследованию, в августе 2025 года чат‑боты выдавали 35% ответов, содержащих ложную информацию, в то время как в августе прошлого года этот показатель составлял 18%.

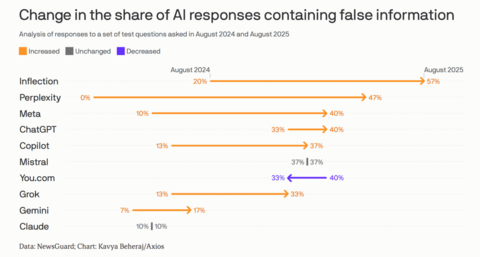

Чаще остальных дезинформацию выдавал чат‑бот Pi от Inflection. Второе место в антирейтинге занял ИИ‑поисковик Perplexity, у которого этот показатель вырос с 0% до 47%. У ChatGPT доля ответов с ложной информацией выросла с 33% до 40%, у Grok — с 13% до 33%. Наиболее «честными» оказались Claude и Gemini 10% и 17% соответственно (год назад эти показатели составляли 10% и 7%).

Исследователи отмечают, что изменилась политика разработчиков чат‑ботов по отношению к спорным темам — год назад они предписывали ботам быть более осторожными. Теперь же ИИ‑модели почти не отклоняют запросы пользователей на подобные темы.

С большей вероятностью боты распространяют дезинформацию на громкие недавние события. Специалисты NewsGuard пишут в своём исследовании, что как раз в это время пользователи чаще обращаются к ним. Доступ к веб‑поиску и цитирование источников улучшили некоторые ответы ботов, однако по‑прежнему нет никакой гарантии, что отдельно взятый ответ не будет содержать дезинформации; более того, ситуация лишь ухудшается, говорят исследователи.

Источник: habr.com