Полное имя билда: Kimi K2 0905.

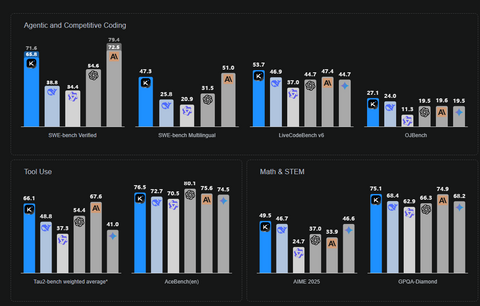

Модель обходит даже Claude 4 Sonnet почти по всем бенчам. Аналогично и с Gemini 2.5 Pro.

Веса — клик

Отчёт — клик (больше бенчей внутри)

Что важно из техчасти

Архитектура: Mixture‑of‑Experts, 32B активных параметров, ~1T total.

Обновление 0905: поддержка agentic coding + контекст до 256K.

Релизы:

Kimi-K2-Base — база для дообучения.

Kimi-K2-Instruct — версия для чатов и агентов (быстрая, без «long thinking»).

Тренировка: 15.5T токенов, оптимизатор MuonClip (qk‑clip) — стабилизирует обучение и убирает всплески логитов внимания.

Оптимизация архитектуры: меньше голов для длинного контекста, больше разреженности в MoE, близко к DeepSeek‑V3.

Агентность: встроенный тул‑юзинг (MCP и синтетические инструменты), генерация агентных данных + общий RL с self‑judge (работает и на проверяемых задачах, и на творческих).

Бенчи (все — non-thinking режим)

Примечания из отчёта: Tau2 — взвешенное среднее; на Swe‑Bench Multilingual сравнивали с Claude Sonnet (Opus пропустили из‑за цены); подчёркнутые/жирные — SOTA, часть метрик взята из техрепортов моделей.

Крутая основа для агентов

Модель можно подключать к своим инструментам без ручного прописывания сценариев. Примеры в отчёте: анализ зарплат с визуализациями, генерация сайтов и планировщиков, автоматизация через терминал, даже прототип Minecraft на JS.

прототип Minecraft на JS

Веса — клик

Отчет — клик (тут больше бенчей, с телефона что то не могу прикрепить остальные)

Все полезные нейронки тут

Друг Опенсурса

Источник: habr.com