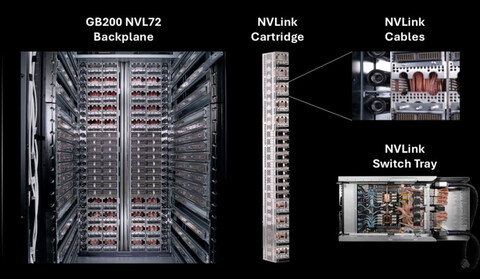

Аналитическое агенство SemiAnalysis опубликовало большой разбор решений для обучения ИИ, в котором пришло к выводу, что для эффективной тренировки передовых моделей на данный момент подходят ускорители Nvidia H100 и H200, а также TPU от Google. Серверные стойки GB200 NVL72 на новейших GPU Nvidia страдают от проблем с медной коммутационной платой NVLink и средствами диагностики и отладки, что приводит к простоям.

Теоретически «отвал» одного чипа не является проблемой — в NVL72 рекомендуется обучать ИИ только на 64 GB200, а еще 8 держать в резерве. Но для их подключения нужно быстро локализовать неисправность, что пока не получается из-за несовершенных средств диагностики. Это значит остановку обучения модели, откат на предыдущий чекпоинт и долгий ремонт неисправности. В SemiAnalysis отмечают, что пока им не известно ни об одном случае завершенной тренировки фронтирной (передовой) модели на GB200 NVL72.

Аналитики рекомендуют использовать GB200 NVL72 для инференса — то есть запуска уже натренированных моделей для конечных пользователей. Сама Nvidia в последних материалах о GB200 NVL72 также на данный момент делает упор на запуск — несмотря на то, что в ранних анонсах компании инференс и тренировка шли параллельно.

В SemiAnalysis прогнозируют, что Nvidia сможет решить проблемы с NVLink и софтом до конца этого года. По подсчетам агентства, стоимость владения в перерасчете на один GPU для GB200 в 1,6-1,7 раза больше, чем для H100 — соответственно, чтобы получить отдачу от новых ускорителей, они должны показывать минимум в 1,6 раз большую производительность при аналогичном времени простоя.

P.S. Поддержать меня можно подпиской на канал «сбежавшая нейросеть», где я рассказываю про ИИ с творческой стороны.

Источник: habr.com