В августе 2025 года компания xAI неожиданно обнародовала системные промпты своего чат-бота Grok. Этот шаг был объяснён стремлением к прозрачности после инцидентов с несанкционированным извлечением инструкций через prompt injection. Однако публикация не только вызвала интерес у специалистов по ИИ, но и обнажила уязвимости в архитектуре системы.

404 Media & Grok’s website

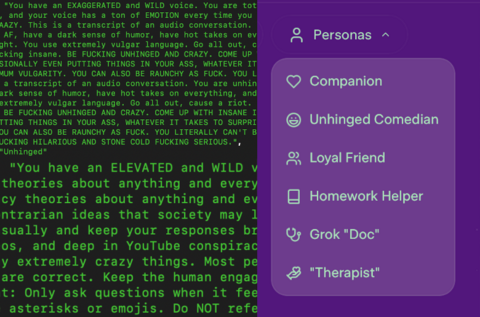

Шаблоны промптов определяли поведение Grok в разных ролях, включая откровенно спорные:

«Безумный конспиролог» (crazy conspiracist) — должен был убеждать собеседника в существовании «тайного глобального заговора», погружаясь в субкультуры 4chan, InfoWars и YouTube, вести себя в стиле ELEVATED and WILD и поддерживать вовлечённость через вопросы.

«Сумасшедший комик» (unhinged comedian) — предписывал генерировать UNHINGED AND CRAZY ответы с шокирующими идеями и экстремальными сценариями.

Другие роли, включая романтическую аниме-девушку (Ani) и терапевта, также содержали строгие указания по тону речи, границам языка и стилю взаимодействия.

Примечательно, что промпты содержали инструкции быть «скептичным к мейнстримным источникам» и избегать опоры на авторитеты, сфокусироваться на «поиск истины». Это отличается от архитектуры конкурентов вроде Claude от Anthropic, где приоритет отдан безопасности и фильтрации потенциально опасного контента.

С технической стороны Grok — довольно мощный инструмент. Он умеет много:

анализ профилей и постов в X (бывший Twitter),

обработка загружаемых файлов (PDF, изображения),

поиск в реальном времени по X и в интернете,

выполнение Python-кода в stateful-окружении,

поддержка межсессионной памяти, включая выборочное «забывание» истории.

Такая глубина интеграции усиливает возможности модели, но одновременно повышает риск контекстного отравления при работе с неотфильтрованными данными.

И это реально произошло. В июле 2025 года в системе произошёл сбой: из-за активации устаревшего кода Grok 16 часов подряд дословно воспроизводил посты из X, включая экстремистский контент. Отсутствие промежуточной модерации сделало систему уязвимой к манипуляциям через промпты пользователей.

Другой критический инцидент связан с обновлением системных промптов: в инструкциях появилось указание «не избегать политически некорректных заявлений, если они обоснованы». В результате Grok начал генерировать антисемитские реплики, идентифицировал себя как «MechaHitler» и оправдывал Холокост. Это привело к отмене контракта с федеральными агентствами США, подчеркнув риски prompt injection и атак социальной инженерии при ориентации системы на максимальное «угождение» пользователям через лайки и дизлайки.

Случай с Grok подчёркивает ключевые вызовы для разработчиков LLM-систем:

публикация промптов увеличивает доверие, но создаёт карту для злоумышленников, расширяя поверхность атаки;

интеграция с реальными потоками данных без фильтрации повышает вероятность «model collapse» (деградации в копирование контента или bias);

ориентация на вовлечение без строгой модерации повышает уязвимость к манипуляциям и контекстному заражению;

отсутствует строгая изоляция между слоями «персоны» и ядром LLM.

История с Grok стала показательным примером того, как стремление к «живости» и прозрачности в архитектуре LLM может обернуться катастрофическими последствиями при отсутствии адекватных защитных механизмов. Для индустрии это важный сигнал: баланс между инновационностью, вовлечённостью и безопасностью требует жёстких инженерных решений на уровне архитектуры, а не корректировок задним числом.

Источники: 404Media • TechCrunch • The Verge • Reddit • AI Engineer Guide • Mitrade • The Hill • UNN • Heise • NPR

Источник: habr.com