Разработчики выпустили Jan-v1 — локальную нейросеть для веб-поиска. Модель конкурирует с Perplexity Pro и опережает её в бенчмарке SimpleQA.

Jan-v1 построена на базе языковой модели Lucy, а для рассуждения использует wen3-4B-Thinking. Модель встроена в фирменное приложение-чат Jan App, но её можно запускать и отдельно от приложения.

В бенчмарке SimpleQA нейросеть набрала 91,1%. Он проверяет возможность модели давать короткий верный ответ на вопрос или воздерживаться, если такого ответа нет. Для сравнения результаты других моделей:

Perplexity Pro — 90,6%;

gpt-oss-20B — 86,3%;

GPT-4.5 — 62,5%;

Gemini-2.5-Pro — 52,9%;

Claude-3.7-Sonnet — 50,0%;

GPT-o3 — 49,4%;

Grok-3 — 44,6%;

GPT-o1 — 42,6%.

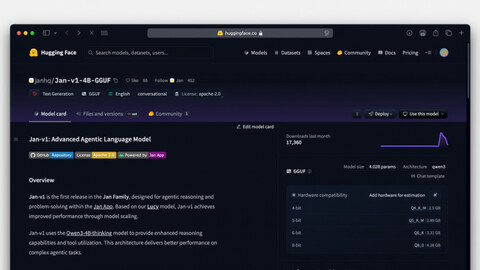

В Hugging Face доступны две версии Jan-v1:

Jan-v1-4B — для запуска с помощью vLLM;

vllm serve janhq/Jan-v1-4B —host 0.0.0.0 —port 1234 —enable-auto-tool-choice —tool-call-parser hermes

Jan-v1-4B-GGUF — для запуска с помощью llama.cpp. Также у этой версии есть популярные квантовки: Q4_K_M (~2.5 ГБ), Q5_K_M (~2.89 ГБ), Q6_K (~3.31 ГБ), Q8_0 (~4.28 ГБ).

llama-server —model Jan-v1-4B-Q4_K_M.gguf —host 0.0.0.0 —port 1234 —jinja —no-context-shift

Рекомендуемые параметры для локального запуска:

temperature: 0.6 top_p: 0.95 top_k: 20 min_p: 0.0 max_tokens: 2048Источник: habr.com