По мнению специалистов Nvidia, индустрия слишком увлеклась крупными языковыми моделями (LLM) для работы агентов — подходом, который, как они утверждают, экономически и экологически нежизнеспособен.

В недавней научной статье они предлагают пересмотреть стратегию: большинство агентов, уверены авторы, могут работать не хуже, если использовать компактные языковые модели (SLM), и призывают компании изменить подход.

В 2024 году рынок API LLM для агентных систем оценивался в 5,6 млрд $, но расходы на облачную инфраструктуру для их работы достигли 57 млрд $ — разрыв 10 к 1. «Эта операционная модель так глубоко вросла в индустрию, что стала фундаментом для масштабных капитальных ставок», — пишут исследователи.

SLM, которые в Nvidia определяют как модели с числом параметров менее 10 млрд, «по сути, обладают достаточной мощностью», «изначально лучше подходят для практического применения» и «неизбежно экономичнее» для большинства агентных задач.

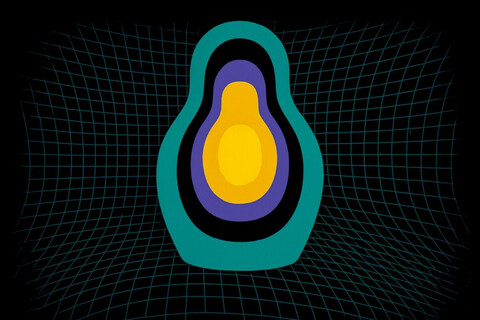

Два способа управления ИИ‑агентами: слева языковая модель отвечает и за общение с пользователем, и за взаимодействие с инструментами. Справа специальный контроллер отделяет оркестрацию инструментов от пользовательского интерфейса, создавая более структурированный рабочий процесс

Исследователи утверждают, что компактные модели нередко способны работать наравне с куда более массивными. Они приводят пример Phi 2 от Microsoft, которая, по их словам, сопоставима с LLM на 30 млрд параметров в задачах логики и программирования, но при этом работает в 15 раз быстрее. Модели Nemotron H от Nvidia — до 9 млрд параметров — демонстрируют аналогичную точность, что и LLM на 30 млрд параметров, при гораздо меньших затратах вычислительных ресурсов. В их перечень попали и Deepseek R1 Distill Qwen 7B, и RETRO от DeepMind, которые, по заявлению авторов, на ключевых задачах не уступают более крупным закрытым аналогам.

Экономика на стороне малых

По расчётам Nvidia, арифметика явно играет в пользу SLM: запуск модели на 7 млрд параметров обходится в 10–30 раз дешевле, чем работа LLM на 70–175 млрд параметров, если учитывать задержки, энергопотребление и вычислительные мощности. Дообучение при этом занимает всего несколько GPU‑часов, а не недели, что позволяет быстро адаптировать модель. Многие SLM могут работать прямо на пользовательском оборудовании, снижая задержки и давая людям больший контроль над своими данными.

Команда подчёркивает, что небольшие модели эффективнее используют параметры, тогда как крупные активируют лишь малую их часть при обработке конкретного запроса, — неэффективность, которую исследователи считают встроенной в архитектуру. По их словам, ИИ‑агенты редко нуждаются во всём спектре возможностей, который предоставляет LLM. «По сути, агент ИИ — это тщательно проинструктированный и внешне срежиссированный шлюз к языковой модели», — отмечают они.

Большинство задач агентов рутинные, узкоспециализированные и лишены продолжительных диалогов, что делает специализированные SLM, подогнанные под конкретный формат, куда более подходящим выбором. Рекомендация Nvidia — строить смешанные агентные системы, в которых SLM используются по умолчанию, а крупные модели подключаются лишь при необходимости сложных рассуждений.

Делегируйте рутинные задачи вместе с BotHub! Сервис доступен без VPN, принимаются российские карты. По ссылке вы можете получить 100 000 бесплатных капсов и приступить к работе с нейросетями прямо сейчас!

Источник: habr.com