X-Omni — методика обучения T2I моделей, которая наглядно доказывает, что RL может вдохнуть новую жизнь в авторегрессионный подход и вывести такие модели на SOTA-уровень.

X-Omni построена на гибридной, но при этом унифицированной архитектуре.

Семантический токенизатор изображений SigLIP-VQ с фиксированным словарем на 16 384 токена кодирует картинку в дискретные токены. Эти визуальные токены вместе с текстовыми подаются в единую авторегрессионную модель на базе Qwen2.5-7B. Наконец, в финальном рендеринге используется диффузионный декодер на основе FLUX.1-dev.

Уникальность метода — в смеси RL по GRPO и комплексной reward-системе

Вместо одного критерия, модель оценивается сразу по нескольким направлениям. За эстетику и соответствие предпочтениям человека отвечает HPSv2 и модель Unified Reward. За семантическую связь между промптом и изображением — VLM-модель Qwen2.5-VL-32B. А за самое сложное, отрисовку текста внутри картинки, отвечает отдельная награда на основе OCR-систем GOT-OCR2.0 и PaddleOCR.

Тестовую модель X-Omni обучали на смеси из 200 млн. изображений, которые после токенизации превратились в 600 млрд мультимодальных токенов, а на этапе SFT использовал ещё 1.5 млрд. токенов.

Для RL-фазы был отобран микс из 180 тыс. промптов, состоящий как из творческие запросы, так и задач на рендеринг текста.

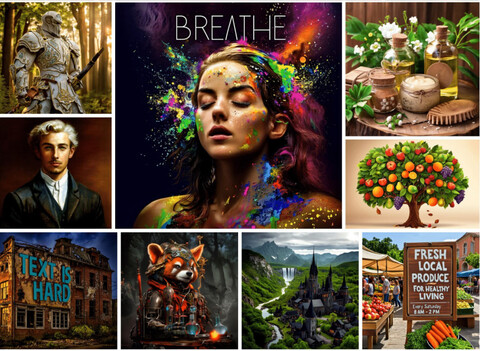

И это дало свои плоды, особенно в отрисовке текста, где авторегрессионные модели исторически пасовали

На бенче OneIG-Bench X-Omni показала результат 0.901 для английского языка, обойдя GPT-4o (0.857). А на собственном LongText-Bench, специально созданном для оценки рендеринга длинных надписей, модель буквально разгромила всех в китайском языке, набрав 0.814 балла против 0.619 у GPT-4o.

В задачах общей генерации по тексту X-Omni также на высоте. На DPG-Bench модель достигла SOTA-результата 87.65, опередив GPT-4o (86.23) и Show-o2 (86.14). На GenEval результат составил 0.83, чуть-чуть не дотянув до модели Mogao (0.89).

Даже в задачах на понимание изображений X-Omni показывает себя достойно: на OCRBench ее результат (704) превосходит другие унифицированные модели, например Emu3 (687).

Интересные подробности

Во-первых, X-Omni не нуждается в CFG. В отличие от Emu3 или Janus-Pro, качество которых резко падает при отключении CFG, X-Omni работает стабильно.

Во-вторых, что, пожалуй, самое важное, RL превосходит даже SFT с последующим сэмплингом best-of-N.

Этот вывод идет вразрез с устоявшимся мнением в области языкового моделирования и доказывает, что для изображений холистическая оптимизация через RL дает существенный прирост качества.

Лицензирование: Apache 2.0 License Страница проекта Набор моделей Arxiv Demo GitHub

Делегируйте часть рутинных задач вместе с BotHub! Для доступа к сервису не требуется VPN и можно использовать российскую карту. По ссылке вы можете получить 100 000 бесплатных токенов для первых задач и приступить к работе с нейросетями прямо сейчас!

Источник: habr.com