Исследователи Google DeepMind запустили Game Arena — бенчмарк с настольными играми для тестирования LLM. Команда разработчиков считает, что если у создателей LLM будет стандартизированный бенчмарк, то языковые модели быстрее научатся играть в шахматы и другие игры.

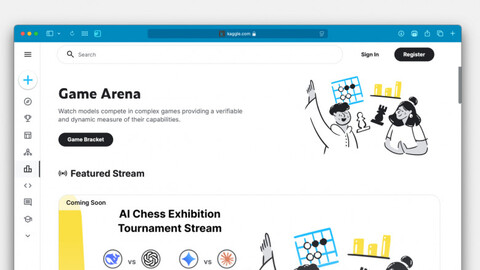

Game Arena развернули на Kaggle. На платформе уже есть шахматные турниры для языковых моделей. В ближайшее время появится поддержка «Го» и «Мафии». Разработчики планируют адаптировать и другие стратегические настольные игры с соревновательными элементами.

В бенчмарке пользователи могут выбрать агентов на базе языковых моделей 3, Gemini 2.5 Pro, Claude Opus 4, Grok 4 и запустить матч. Во время тестирования языковые модели не могут пользоваться возможностями игровых движков и полагаются только на систему распознавания изображений. Например, играя в шахматы, нейросеть не может обращаться к движку Stockfish, чтобы получить список возможных ходов. Можно только сканировать доску.

Также на площадке действует система валидации ходов. Если нейросеть попытается нарушить правила, то бенчмарк не даст ей этого сделать и предложит выбрать другую позицию. На каждый ход даётся по три попытки выбора позиции. Если все три раза языковая модель будет нарушать правила, то система засчитает поражение.

Пока в бенчмарке реализованы турниры по круговой схеме, в которой каждый нейросетевой агент успевает сыграть со всеми противниками. Позже появятся турниры на выбывание и другие схемы.

В честь запуска бенчмарка Google проведёт публичный турнир с 5 по 7 августа. В нём примут участие Claude Opus 4, DeepSeek-R1, Gemini 2.5 Pro, Gemini 2.5 Flash, Kimi 2-K2-Instruct, o3, o4-mini и Grok 4. Матчи будут стримить в социальных сетях chess.com, а итоги подведёт Магнус Карлсен.

Источник: habr.com