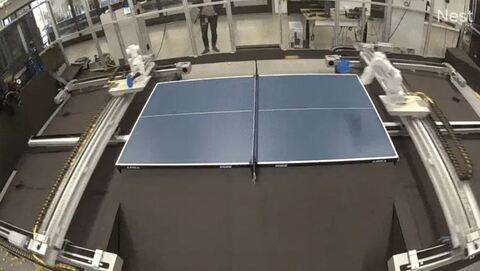

В Google DeepMind установили пару роботизированных рук для бесконечной игры в настольный теннис. Цель этого проекта, начатого в 2022 году, — дать двум роботам возможность непрерывно учиться друг у друга посредством соревнования.

В игре нет финального счёта, которого роботы могут достичь, чтобы завершить битву. Они продолжают соревноваться бесконечно, стремясь к совершенствованию с каждым ударом. В настоящее время роборуки не способны соревноваться с опытными игроками-людьми, но они уже доминируют над новичками. Против игроков среднего уровня шансы роботов составляют примерно 50/50.

Проект нацелен на создание продвинутой универсальной модели ИИ, которая могла бы служить «мозгом» человекоподобных роботов, способных взаимодействовать с людьми на реальных заводах, в домах и за их пределами. Исследователи из DeepMind и других организаций надеются, что этот метод обучения, если его масштабировать, может стать «моментом ChatGPT» в робототехнике. «Мы настроены оптимистично и считаем, что продолжение исследований в этом направлении приведёт к созданию более адаптируемых машин, способных обучаться разнообразным навыкам, необходимым для эффективной и безопасной работы в нашем неструктурированном мире», — отмечают старший инженер DeepMind Паннаг Санкети и профессор Университета штата Аризона Хени Бен Амор.

Оказывается, настольный теннис — довольно эффективный способ погрузить роботов в непредсказуемую среду. Этот вид спорта используется в качестве эталона для исследований в области робототехники с 1980-х годов, поскольку он сочетает в себе скорость, реакцию и стратегию. Чтобы добиться успеха, игрок должен овладеть целым рядом навыков, в том числе тонкой моторикой и перцептивными способностями. В то же время роботу приходится принимать стратегические решения о том, как переиграть соперника и когда следует пойти на продуманный риск. Исследователи DeepMind описывают игру как «ограниченную, но в то же время чрезвычайно динамичную среду».

В DeepMind начали проект, используя обучение с подкреплением, чтобы научить роботизированную руку основам этого вида спорта. Сначала обе руки были обучены просто участвовать в совместных розыгрышах, поэтому ни у одной из них не было причин пытаться выиграть очки. В конце концов, после некоторой доработки инженерами, команда представила двух роботов-агентов, способных автономно поддерживать длительные розыгрыши. После этого исследователи скорректировали параметры и дали команду роборукам попытаться выиграть. Этот процесс, как они писали, быстро подавлял ещё неопытных роботов. Во время розыгрыша роборуки получали новую информацию и осваивали новую тактику, но затем забывали некоторые из предыдущих ходов. Результатом стал постоянный поток коротких розыгрышей, часто заканчивавшихся тем, что один из роботов забивал победный слэм.

Роботы показали заметный скачок в улучшении результатов, когда им было поручено играть в розыгрыши против соперников-людей. Вначале люди разного уровня подготовки лучше удерживали мяч в игре. Это оказалось решающим фактором в улучшении производительности роботов.

Со временем оба робота совершенствовались, повышая не только свою стабильность, но и способность разыгрывать более сложные моменты, сочетая защиту, нападение и большую непредсказуемость. В общей сложности роботы выиграли 45% из 29 игр против людей, в том числе в 55% случаев обыгрывая игроков среднего уровня.

Исследователи отмечают, что они постоянно совершенствуются. Отчасти этот прогресс был достигнут благодаря новому виду обучения с помощью ИИ. DeepMind использует модель зрительного восприятия Google Gemini для просмотра видеозаписей игры роботов и формирования обратной связи о том, как лучше набирать очки. Видеоролики «Coach Gemini» в действии показывают, как робот-манипулятор корректирует свою игру в ответ на команды ИИ, такие как «бей мяч как можно правее». DeepMind и другие компании надеются, что агенты, конкурирующие друг с другом, помогут улучшить универсальное программное обеспечение ИИ способом, который будет больше походить на то, как люди учатся ориентироваться в окружающем мире. Хотя ИИ может легко превзойти большинство людей в таких задачах, как базовое программирование или шахматы, даже самые продвинутые роботы с ИИ с трудом ходят с той же устойчивостью, что и ребенок. Задачи, которые изначально просты для людей — например, завязывание шнурков или набор букв на клавиатуре — остаются колоссальными проблемами для роботов. Эта дилемма, известная в сообществе робототехники как парадокс Моравеца, остаётся одним из самых больших препятствий на пути к созданию робота, который действительно мог бы быть полезен по дому.

Появляются некоторые первые признаки того, что эти препятствия преодолимы. В прошлом году DeepMind наконец-то удалось научить робота завязывать шнурки. В этом году Boston Dynamics выпустила видео, на котором автономный робот Atlas в режиме реального времени корректирует ошибки, допущенные при загрузке материалов на макете производственного объекта.

Ранее в DeepMind начали разрабатывать систему, которая обеспечит ИИ-агентов «внутренним голосом», чтобы помочь им более эффективно изучать задачи и в итоге стать «умнее».

Источник: habr.com