Новая архитектура под названием Energy-Based Transformer призвана научить модели ИИ решать задачи аналитически и поэтапно.

Большинство современных моделей ИИ работают по принципу, который Дэниел Канеман назвал «System 1 thinking»: они быстрые, интуитивные и отлично справляются с распознаванием образов. Но, согласно исследованию, проведённому учёными из Университета Вирджинии, Университета Иллинойса в Чикаго, Стэнфорда, Гарварда и Amazon GenAI, эти модели часто не справляются с задачами, требующими более медленного и аналитического «System 2 thinking», например со сложными логическими рассуждениями или продвинутой математикой.

В статье «Трансформеры на основе энергии — масштабируемые обучающиеся и мыслящие системы» задаётся вопрос, могут ли подобные навыки мышления развиться исключительно в результате обучения без учителя. Исследователи предлагают новую архитектуру: Energy-Based Transformer (EBT).

Как работают Energy-Based Transformers

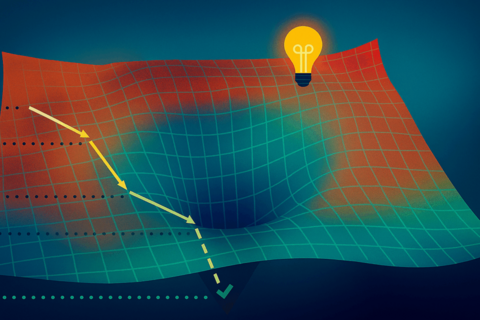

Подход EBT рассматривает мышление как итеративный процесс оптимизации. Вместо того чтобы генерировать ответ за один шаг, модель начинает со случайного решения. Затем она оценивает это решение, вычисляя значение «энергии».

Чем ниже энергия, тем лучше прогноз соответствует контексту. Благодаря многократным корректировкам с помощью градиентного спуска ответ постепенно уточняется, пока энергия не достигнет минимума. Это позволяет модели тратить больше вычислительных ресурсов на решение более сложных задач.

Идея рассматривать этот процесс с точки зрения энергии не нова: главный специалист Meta* по искусственному интеллекту Янн ЛеКун и другие учёные уже много лет обсуждают «модели, основанные на энергии».

Более эффективное обучение и обобщение

В ходе экспериментов исследователи сравнили EBT с усовершенствованным вариантом Transformer (Transformer++). Их результаты показывают, что EBT масштабируются более эффективно: в статье сообщается о повышении скорости масштабирования на 35% с точки зрения данных, количества параметров и вычислительных ресурсов. Это указывает на повышение эффективности использования данных и вычислительных ресурсов.

Однако настоящая сила проявляется в том, что авторы называют «масштабируемостью мышления», то есть в способности повышать производительность за счёт дополнительных вычислений во время выполнения. При решении языковых задач EBT повысили производительность на 29%, особенно при решении задач, которые значительно отличались от обучающих данных.

В тестах по шумоподавлению изображений EBT превзошли Diffusion Transformers (DiT), при этом им потребовалось на 99% меньше вычислительных шагов. Исследование также показало, что EBT научились представлять изображения так, что точность классификации на ImageNet-1k выросла примерно в десять раз, что говорит о более глубоком понимании контента.

Сохраняются значительные препятствия

Несмотря на эти многообещающие результаты, остаются открытыми некоторые вопросы. Основная проблема связана с вычислениями: согласно статье, для обучения EBT требуется в 3,3–6,6 раза больше вычислительной мощности (флопов), чем для стандартных трансформеров. Эти дополнительные затраты могут стать препятствием для многих реальных приложений. В исследовании «System 2 thinking» оценивается в основном по улучшению показателя сложности, а не по реальным задачам на логическое мышление, а сравнение с современными моделями логического мышления отсутствует из-за ограниченного вычислительного бюджета.

Все прогнозы по масштабированию основаны на экспериментах с моделями, содержащими до 800 миллионов параметров, что намного меньше, чем у крупнейших современных систем искусственного интеллекта. Пока неясно, сохранятся ли преимущества EBT при более крупных масштабах.

Делегируйте часть рутинных задач вместе с BotHub! Для доступа к сервису не требуется VPN и можно использовать российскую карту. По ссылке вы можете получить 100 000 бесплатных токенов для первых задач и приступить к работе с нейросетями прямо сейчас!

*Meta и её продукты (Instagram, Facebook) запрещены на территории Российской Федерации

Перевод, источник новости здесь.

Источник: habr.com