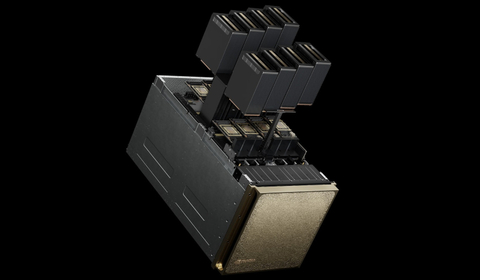

NVIDIA объявила о стратегическом партнёрстве с Google Cloud с целью внедрения агентного ИИ на предприятиях, которые хотели бы локально использовать семейство моделей Google Gemini с помощью платформ NVIDIA Blackwell HGX/DGX, а также функции NVIDIA Confidential Computing для повышения безопасности данных.

Интеграция платформы NVIDIA Blackwell с портфелем программно-аппаратных решений Google Distributed Cloud позволяет локальным ЦОД соответствовать нормативным требованиям и законам о суверенитете данных, блокируя доступ к конфиденциальной информации, включая истории болезни пациентов, финансовые транзакции и секретную правительственную информацию. NVIDIA Confidential Computing защищает конфиденциальный код в моделях Gemini от несанкционированного доступа и утечек данных — запросы пользователя к API Gemini, а также данные, которые они использовали для тонкой настройки, остаются в безопасности и защищены от несанкционированного доступа или изменений.

Сачин Гупта (Sachin Gupta), вице-президент и генеральный менеджер по инфраструктуре и решениям в Google Cloud, отметил, что партнёрство позволяет предприятиям в полной мере использовать весь потенциал агентного ИИ, внедряя модели Gemini в локальные системы, и объединяя производительность NVIDIA Blackwell и возможности конфиденциальных вычислений.

Хотя многие уже могут использовать модели с мультимодальным рассуждением — интегрируя текст, изображения, код и другие типы данных для решения сложных проблем и создания облачных приложений агентного ИИ, предприятия с повышенными требованиями к безопасности или суверенитету данных столкнулись с трудностями при внедрении этих технологий. Данное партнёрство позволит решить эти проблемы, благодаря чему Google Cloud становится одним из первых поставщиков, предлагающих возможности конфиденциальных вычислений для защиты рабочих нагрузок ИИ-агентов в любой среде, как облачной, так и гибридной.

Источник изображения: NVIDIA

Масштабирование агентного ИИ требует надёжного мониторинга и безопасности для обеспечения стабильной производительности и соответствия требованиям. Google Cloud представила новый шлюз GKE Inference Gateway, созданный для оптимизации развёртывания рабочих нагрузок ИИ-агентов с расширенной маршрутизацией и масштабируемостью. Интеграция с NVIDIA Triton Inference Server и NVIDIA NeMo Guardrails обеспечивает интеллектуальную балансировку нагрузки, которая повышает производительность и снижает затраты на обслуживание, также обеспечивая централизованную безопасность и управление моделями.

В дальнейшем Google Cloud планирует улучшить отслеживания рабочих нагрузок агентского ИИ, интегрировав NVIDIA Dynamo, библиотеку с открытым исходным кодом, предназначенную для обслуживания и масштабирования рассуждающих моделей. Этот перспективный подход гарантирует, что предприятия смогут уверенно масштабировать свои приложения агентского ИИ, сохраняя при этом безопасность и соответствие требованиям.

Источник: servernews.ru