Мощная рассуждающая языковая модель с открытым исходным кодом QwQ-32B теперь доступна в Ollama. Это среднеразмерная модель с 32.5 миллиардами параметров из серии Qwen разработана для выполнения сложных задач и демонстрирует конкурентоспособное качество по сравнению с другими reasoning моделями, такими как DeepSeek-R1.

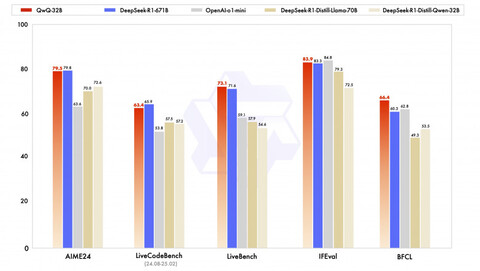

QwQ-32B обладает точностью ответах, в некоторых тестах достигающей 90%, что на 21% выше, чем в тестах Llama 70B. При этом модель вдвое меньше Llama 70B и в 20 раз меньше DeepSeek R1 при сравнимой производительности. Это делает QwQ-32B привлекательным выбором для разработчиков и исследователей, ищущих высокопроизводительные модели, но не обладающие избыточными вычислительными ресурсами.

Вы можете попробовать данную модель на серверах с GPU начиная от 2xRTX 4090 или 2x7900XTX, но рекомендуются GPU с 48+ Гб видеопамяти, такие как H6000, A100 или H100, особенно при использовании большого размера контекста. Модель прекрасно работает в связке Ollama + OpenWebUI.

Источник: habr.com