Исследование некоммерческого исследовательского института Epoch AI показало, что ChatGPT может быть не таким энергоёмким, как предполагалось ранее. Однако энергопотребление зависит от того, как используется чат-бот и какие модели ИИ отвечают на запросы.

Стандартная статистика гласит, что ChatGPT требует около 3 ватт-часов энергии для ответа на один вопрос — в 10 раз больше, чем поисковик Google.

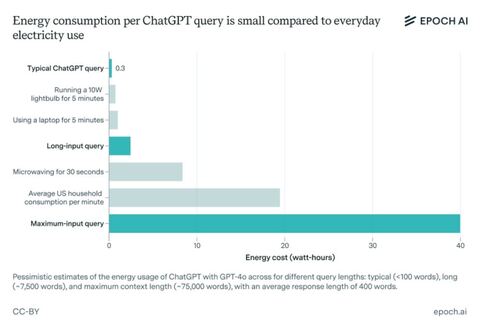

Используя модель OpenAI GPT-4o в ChatGPT, исследователи Epoch обнаружили, что при обычном запросе она потребляет около 0,3 ватт-часов — меньше, чем многие бытовые приборы.

Аналитик данных Джошуа Ю решил провести исследование, чтобы проверить данные первых отчётов. Например, в работе, которая оценивала энергопотребление ChatGPT в 3 ватт-часа, предполагалось, что OpenAI использует старые и менее эффективные чипы для запуска своих моделей.

При этом в Epoch признают, что данные их исследования нельзя назвать абсолютно точными, так как анализ также не учитывает дополнительные затраты энергии на генерацию изображений или обработку ввода.

Джошуа Ю ожидает, что базовое энергопотребление ChatGPT возрастёт. «Искусственный интеллект станет более продвинутым, обучение этого ИИ, вероятно, потребует гораздо больше энергии, и этот будущий искусственный интеллект может использоваться гораздо интенсивнее — для решения гораздо большего количества задач и более сложных задач, чем сегодня», — пояснил он.

Согласно отчёту Rand, в ближайшие два года центрам обработки данных искусственного интеллекта может потребоваться мощность, аналогичная потреблению всей Калифорнии в 2022 году (68 ГВт). К 2030 году обучение пограничной модели может потребовать выходной мощности, эквивалентной мощности восьми ядерных реакторов (8 ГВт).

Кроме того, OpenAI наравне с другими компаниями переключается на модели рассуждений, которые, как правило, более эффективны с точки зрения задач, но требуют больше вычислений для запуска. «Модели рассуждений будут всё чаще брать на себя задачи, с которыми не могут справиться старые модели, и генерировать больше данных, а это требует больше центров обработки данных», — сказал Джошуа Ю.

OpenAI начала выпускать более энергоэффективные модели рассуждений, такие как o3-mini. Но кажется маловероятным, по крайней мере на данном этапе, что это компенсирует возросшие требования к мощности. Тем, кто беспокоится о потреблении энергии, исследователи посоветовали использовать более мелкие модели ИИ, такие как GPT-4o-mini, но только для действительно важных задач.

Между тем основатель Microsoft Билл Гейтс считает, что не стоит беспокоиться о потреблении энергии для нужд искусственного интеллекта. Он уверен, что ИИ в конечном итоге сам найдёт способы снижения энергопотребления и перехода к устойчивой энергетике.

Однако в отчёте самой Microsoft в 2024 году указывалось, что энергопотребление и выбросы углекислого газа ЦОД выросли на 29%, а компания использовала на 23% больше воды, чем годом ранее.

Кроме того, исследователи из Калифорнийского университета выяснили, что рост популярности искусственного интеллекта может оказать существенное воздействие на окружающую среду. Предварительные подсчёты университета показывают, что всего лишь на пять запросов к ChatGPT дата-центр Microsoft в Айове расходует 0,5 л воды.

Источник: habr.com