Исследователи Meta AI и их академические партнёры разработали систему, которая обучает большие языковые модели работе с изображениями, видео и аудио без специальной подготовки.

Система под названием MILS (Multimodal Iterative LLM Solver) опирается на естественные способности моделей к решению задач, а не на обширную подготовку данных.

MILS работает в паре с двумя моделями AI: «генератором», который предлагает решения задач, и «оценщиком», который оценивает эффективность этих решений. Обратная связь от «оценщика» помогает «генератору» шаг за шагом улучшать свои ответы, пока не будет достигнут удовлетворительный результат.

Точность описания изображения увеличивается с увеличением количества шагов между генератором и оценщиком.

Система особенно хорошо справляется с описанием изображений. Используя Llama-3.1-8B в качестве генератора и CLIP в качестве оценщика, MILS создаёт подробные описания изображений, которые соответствуют или превосходят современные передовые методы, даже несмотря на то, что CLIP не был специально обучен для выполнения этой задачи.

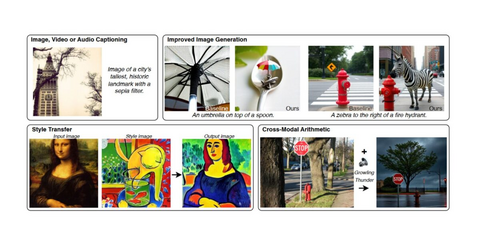

MILS также способствует улучшению процесса создания изображений из текста благодаря точной настройке текстовых инструкций. Кроме того, система может выполнять задачи по редактированию изображений, такие как перенос стиля, комбинируя подсказки, созданные искусственным интеллектом, с инструментами обработки изображений.

Из простого базового описания пейзаж превращается в сложное изображение ландшафта с более точными деталями и естественными элементами.

Возможности системы распространяются также на видео и аудио. В тестах с использованием набора данных о видео MSR-VTT система MILS показала лучшие результаты, чем существующие модели, при описании видеоконтента.

Поскольку MILS не изменяет параметры модели во время работы, он может преобразовывать различные типы данных в читаемый текст. Это позволяет создавать новые приложения, например, объединять информацию из нескольких источников, таких как изображения и аудио, преобразуя всё в текст, объединяя информацию, а затем преобразуя её обратно в нужный формат.

Тесты показывают, что более крупные модели-генераторы и модели-оценщики дают более точные результаты, а наличие большего количества потенциальных решений для работы повышает производительность. Исследователи обнаружили, что переход к более крупным языковым моделям также приводит к заметному улучшению качества.

Сфера AI быстро смещается в сторону моделей, которые могут обрабатывать несколько типов входных данных, так называемую мультимодальность. В то время как GPT-4 от OpenAI лидировал в этой области, альтернативы с открытым исходным кодом не отставали: Llama 3.2 от Meta, Pixtral от Mistral и Janus Pro от DeepSeek могут обрабатывать изображения вместе с текстом — это ключевая особенность для систем AI, которые должны быть действительно полезными в повседневных ситуациях.

MILS использует другой подход к мультимодальности, перенося требования к обучению на предварительно обученную модель. Эта стратегия соответствует текущему направлению развития в этой области — совершенствованию языковых моделей с помощью более эффективных методов вывода, а не просто добавлением дополнительных обучающих данных. Заглядывая в будущее, исследовательская группа видит потенциал MILS в обработке трёхмерных данных.

*Meta и её продукты (Facebook, Instagram) запрещены на территории Российской Федерации

Источник

Источник: habr.com