За последние десятилетия ученые в области компьютерных наук разработали всё более продвинутые модели искусственного интеллекта (AI), некоторые из которых способны выполнять определенные задачи на уровне человека. Однако, насколько эти модели действительно “думают” и анализируют информацию, как люди, до сих пор остается предметом ожесточенных дискуссий.

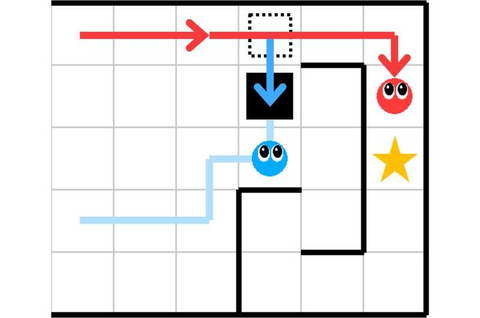

Задание «помочь или помешать»; одна из задач, использованных для тестирования зрительной когнитивной способности мультимодальных LLM. Источник: MIT.

Исследователи из Института биологической кибернетики Макса Планка, Института AI, ориентированного на человека в Helmholtz Munich, и Университета Тюбингена недавно решили глубже понять, насколько мульти-модальные модели большого языка (LLM), перспективный класс AI, способны осознавать сложные взаимодействия и отношения в задачах визуального восприятия. Их результаты, опубликованные в журнале Nature Machine Intelligence, показывают, что, хотя некоторые модели LLM хорошо справляются с обработкой и интерпретацией данных, они часто не улавливают тонкости, которые легко понимают люди.

“Мы были вдохновлены статьей Брэндена М. Лейка и других исследователей, которая описывала ключевые когнитивные компоненты, необходимые для того, чтобы машинное обучение можно было считать схожим с человеческим,” рассказали авторы статьи Лука М. Шульце Бушхофф и Элиф Аката в интервью Tech Xplore.

“Когда мы начали свой проект, наблюдался многообещающий прогресс в языковых моделях с визуальными возможностями, способных обрабатывать как язык, так и изображения. Однако оставались вопросы, могут ли эти модели выполнять визуальные задачи на уровне человека.”

Основная цель недавнего исследования Бушхоффа, Акаты и их коллег состояла в том, чтобы оценить способность мульти-модальных LLM улавливать такие аспекты визуальных задач, как интуитивное понимание физики, причинно-следственные связи и предпочтения людей. Это может помочь выяснить, насколько способности этих моделей действительно можно считать похожими на человеческие.

Для этого исследователи провели серию контролируемых экспериментов, проверяя модели на задачах, взятых из психологических исследований. Этот подход был впервые использован в предыдущей работе Марселя Бинца и Эрика Шульца, опубликованной в PNAS.

“Например, чтобы проверить их понимание интуитивной физики, мы показывали моделям изображения башен из блоков и просили оценить, устойчива ли башня,” объяснили Бушхофф и Аката.

“Для проверки причинного мышления и интуитивной психологии модели должны были выявить взаимосвязи между событиями или понять предпочтения других агентов. Мы оценили их производительность и сравнили с результатами людей, которые участвовали в тех же экспериментах.”

Сравнивая ответы LLM с ответами людей, исследователи смогли лучше понять, в чем модели были близки к человеческому мышлению, а в чем — отставали. В целом, их результаты показали, что хотя некоторые модели хорошо справляются с обработкой базовых визуальных данных, они по-прежнему испытывают трудности в воспроизведении более сложных аспектов человеческого восприятия.

“Пока неясно, можно ли это исправить с помощью увеличения масштабов обучения или разнообразия данных,” отметили Бушхофф и Аката.

“Это связано с более широкой дискуссией о том, какие индуктивные предубеждения нужны этим моделям. Например, некоторые утверждают, что модели должны быть оснащены базовыми модулями обработки, такими как физический движок, чтобы достичь более общего и устойчивого понимания физического мира. Это даже напоминает исследования детей, которые показывают, что они могут предсказывать физические процессы с раннего возраста.”

Работа Бушхоффа, Акаты и их коллег проливает новый свет на то, насколько современные мульти-модальные LLM обладают когнитивными навыками, похожими на человеческие. На данный момент команда тестировала модели, предварительно обученные на больших наборах данных, но в будущем они планируют провести дополнительные тесты с моделями, которые были дообучены на задачах, используемых в экспериментах.

“Наши первые результаты по дообучению показывают, что модели действительно лучше справляются с конкретными задачами, на которые они были натренированы”, “Однако эти улучшения не всегда переносятся на более обобщенные задачи, что люди делают очень хорошо,” добавили Бушхофф и Аката.

Работа команды подчеркивает, что, хотя современные модели AI могут достигать впечатляющих результатов в решении отдельных задач, им все еще не хватает способности к общему пониманию, характерному для человеческого разума. Это ставит вопрос о том, как именно улучшать и обучать такие модели, чтобы они могли действительно эмулировать человеческие когнитивные способности на более широком уровне.

Источник

Источник: habr.com