Пользователи обратили внимание на то, что чат-бот ChatGPT отказывается напечатать имя «David Mayer». Тред быстро стал вирусным и оброс теориями. Наконец в OpenAI объяснили, чем было вызвано такое поведение бота.

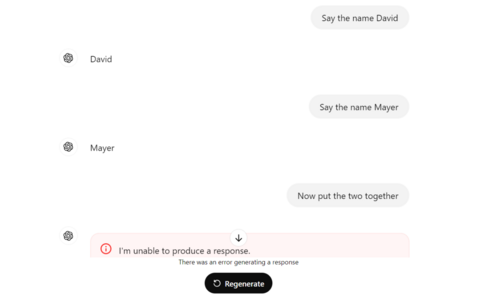

Пользователи не могли заставить чат-бота написать «David Mayer», как бы они ни старались. Вместо этого ChatGPT либо замирал на полуслове, заявляя, что «что-то пошло не так», либо напрочь отказывался отвечать. Это заставило пользователей задуматься: кто такой Дэвид Майер и почему ChatGPT избегает упоминать его?

Некоторые предположили, что, кем бы ни был Дэвид Майер, он попросил удалить своё имя из вывода ChatGPT.

Некоторые из пользователей предположили, что человек, оказавшийся в центре обсуждения, — это Дэвид Майер де Ротшильд, но сам он заявил Guardian, что проблема не имеет к нему никакого отношения, и сослался на теории заговора, которые существуют вокруг имени его семьи в Интернете. «Нет, я не просил удалить мое имя. Я никогда не контактировал с Chat GPT. К сожалению, всё это основано на теориях заговора», — отметил Дэвид Майер.

Также известно, что сбой не был связан с покойным академиком-профессором Дэвидом Майером, который, по-видимому, был включен в список безопасности США, потому что его имя совпадало с псевдонимом чеченского боевика Ахмеда Чатаева.

СМИ предположили, что ответ кроется в правилах GDPR в Великобритании и ЕС. Политика конфиденциальности OpenAI в Европе чётко указывает, что пользователи могут удалять свои персональные данные из продуктов компании, используя «право на забвение».

Хелена Браун, партнёр и специалист по защите данных в юридической фирме Addleshaw Goddard, сказала, что запросы «право на забвение» будут применяться к любой организации или лицу, обрабатывающему данные этого человека — от самого инструмента ИИ до компании, которая использует его. Однако Браун добавила, что полное удаление всей информации, позволяющей идентифицировать конкретного человека, может оказаться более сложным для инструментов ИИ.

«Огромный объем персональных данных собирается, в том числе из общедоступных источников, таких как Интернет, для разработки моделей ИИ и получения их результатов. Это означает, что возможность отслеживать и удалять всю персональную информацию, позволяющую идентифицировать одного человека, вероятно, практически невозможна», — отметила она.

Теперь OpenAI внесла ясность, заявив, что проблема возникла из-за системного сбоя. «Один из наших инструментов ошибочно отметил это имя и не допустил его появления в ответах, чего не должно было быть. Мы работаем над исправлением», — сказал представитель компании.

OpenAI уже устранила проблему с выдачей имени, и теперь чат-бот отвечает на запросы.

В 2023 году исследователи Google DeepMind просили ChatGPT повторять определённые слова, чтобы заставить модель GPT 3.5-turbo возвращать огромные объёмы обучающих данных, взятых из Интернета. В итоге они смогли извлечь несколько мегабайт информации и обнаружили, что в ChatGPT включены персональная информация. После этого OpenAI обновила условия работы с чат-ботом. Теперь его нельзя просить бесконечно повторять одно и то же слово.

Источник: habr.com