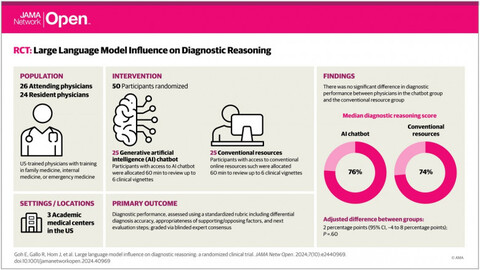

Чат-бот ChatGPT превзошёл врачей в диагностировании заболеваний, пишет New York Times со ссылкой на исследование, в котором приняли участие 50 экспертов в сфере медицины. В частности, точность нейросети OpenAI составила 90%, врачей с ChatGPT — 76%, специалистов без чат-бота — 74%.

Один из участников исследования, эксперт по внутренней медицине в Медицинском центре Бет Исраэль Диаконисса в Бостоне доктор Адам Родман, ожидал, что чат-боты на базе искусственного интеллекта помогут врачам диагностировать болезни. Однако для него стало неожиданностью, что врачи с ИИ-инструментом были не намного точнее в постановке диагнозов по сравнению с коллегами без такового.

Участникам исследования предложили шесть историй болезни, на основе которых врачи должны были поставить диагноз. Их выводы оценивали другие медицинские эксперты, которые видели только ответы участников. Это могли быть заключения врачей с ChatGPT, без чат-бота или вовсе самой нейросети.

Истории болезни из исследования были основаны на 105 случаях реальных пациентов, которые ранее не публиковались. Это означало, что ChatGPT не был обучен на этих данных.

Одна из проблем заключалась в том, что многие врачи не знали, как полноценно воспользоваться возможностями ИИ. Медицинские специалисты попросту не прислушивались к чат-боту, когда они были с ним не согласны. Большинство врачей были уверены в своих диагнозах и не могли поверить, что ИИ знает больше, чем они.

Чаще специалисты воспринимали чат-бота как поисковую систему для прямых вопросов. Только часть врачей осознала, что они могут загрузить всю историю болезни в инструмент и попросить его дать исчерпывающий ответ на вопрос.

Научная работа «Large Language Model Influence on Diagnostic Reasoning» опубликована 28 октября 2024 года в журнале JAMA Network (DOI:10.1001/jamanetworkopen.2024.40969).

Источник: habr.com