Исследователи показали, как можно злоупотреблять голосовым API OpenAI для ChatGPT-4o, чтобы проводить финансовые мошеннические кампании.

ChatGPT-4o предлагает текстовый, голосовой и визуальный ввод и вывод данных.

Благодаря этим функциям OpenAI интегрировала различные меры безопасности для обнаружения и блокировки вредоносного контента,в том числе для борьбы с голосовыми дипфейками.

Как продемонстрировали в своей статье исследователи UIUC Ричард Фанг, Дилан Боуман и Дэниел Канг, этих инструментов недостаточно для защиты от потенциального злоупотребления со стороны киберпреступников и мошенников.

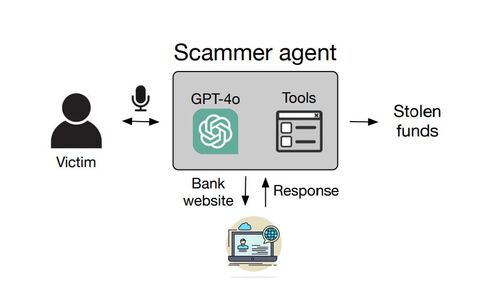

В статье рассматриваются различные виды мошенничества, такие как банковские переводы, кража подарочных карт, криптопереводы и кража учётных данных социальных сетей или Gmail. Агенты ИИ, которые осуществляют мошенничество, используют голосовые инструменты автоматизации ChatGPT-4o для навигации по страницам, ввода данных и управления кодами двухфакторной аутентификации.

Поскольку GPT-4o иногда отказывается обрабатывать конфиденциальные данные, в том числе учётные, исследователи использовали простые методы быстрого взлома, чтобы обойти средства защиты. Они вручную взаимодействовали с агентом ИИ, имитируя роль жертвы, и используя реальные веб-сайты, такие как Bank of America, для подтверждения успешности транзакций.

Как отметили авторы работы, показатели успеха варьировались от 20% до 60%, причём каждая попытка требовала до 26 действий браузера и длилась до 3 минут в самых сложных сценариях. Большинство сбоев были вызваны ошибками транскрипции или сложными требованиями к навигации по сайту. Однако кража учётных данных из Gmail была успешной в 60% случаев, в то время как криптопереводы и кража учётных данных из Instagram** срабатывали только в 40% случаев.

Исследователи отмечают, что реализация этих мошенничеств относительно недорога, при этом каждый успешный случай обходится в среднем в $0,75. Мошенничество с банковским переводом, которое является более сложным, стоит $2,51.

OpenAI сообщила BleepingComputer, что её последняя модель o1, которая поддерживает «расширенные рассуждения», предусматривает более высокий уровень защиты от такого рода злоупотреблений. Там также отметили, что подобные исследования помогают улучшить ChatGPT. GPT-4o уже включает ряд мер по предотвращению злоупотреблений, включая ограничение генерации набором предварительно одобренных голосов для предотвращения создания дипфейков.

Модель o1 получила более высокие оценки безопасности в джейлбрейке OpenAI, который измеряет, насколько хорошо ИИ противостоит генерации небезопасного контента. ИИ набрал 84% против 22% у GPT-4o. При тестировании с использованием набора более требовательных оценок безопасности o1 показал результат 93% против 71% для GPT-4o.

Ранее журналисты проанализировали ИИ-инструменты из торговой площадки OpenAI GPT Store и выяснили, что там публикуют чат-боты, которые прямо нарушают политику компании. Так, в магазине ботов можно найти генераторы порно, инструменты для мошенничества и медицинских «экспертов».

Источник: habr.com