Компании все больше беспокоятся о том, что внедрение искусственного интеллекта (ИИ) увеличивает их уязвимость к киберугрозам. По результатам недавнего опроса среди более 350 ИТ-руководителей, более половины респондентов отметили, что сложность ИИ-приложений негативно сказывается на кибербезопасности их организаций. Кроме того, более двух пятых опрошенных заявили, что их команды по безопасности не обладают необходимыми навыками для защиты ИИ-приложений и рабочих нагрузок.

Растущий спрос на защиту ИИ-приложений привёл к возникновению ряда стартапов, таких как HiddenLayer и Protect AI, которые специализируются на защите систем ИИ от атак, а также Cranium, который обеспечивает прозрачность работы ИИ-систем. Новая компания, Noma Security, основанная Нивом Брауном и Алоном Троном, предлагает комплексные решения для защиты данных и ИИ-приложений.

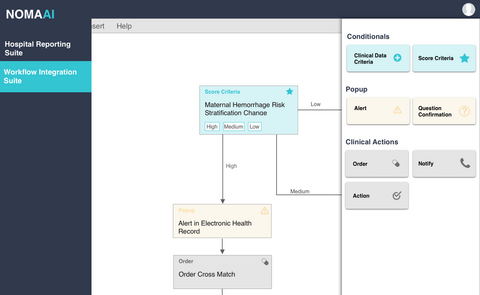

Noma разрабатывает инструменты для выявления уязвимых каналов передачи данных и кода, а также для защиты от угроз, таких как атаки с внедрением команд. Браун, ранее работавший в компании Verint, заметил значительные недостатки в подходах к безопасности на протяжении всего жизненного цикла данных и ИИ.

«Существующие инструменты ориентированы на традиционный жизненный цикл ПО, — поясняет он. Однако жизненный цикл данных и ИИ отличается и требует уникальных подходов».

Noma предлагает платформу, которая помогает выявлять и исправлять неправильные настройки компонентов, используемых для разработки и запуска ИИ-приложений, включая сканирование наборов данных на наличие конфиденциальной информации.

Стартап уже заручился поддержкой клиентов, включая компании из списка Fortune 500, и завершил раунд финансирования серии A на сумму 25 миллионов долларов. Noma планирует удвоить свою команду в следующем году и активно развивать свои решения для улучшения кибербезопасности в сфере ИИ.

Источник

Источник: habr.com