Исследователи обнаружили, что медицинский ИИ Whisper для транскрипции встреч с пациентами на основе модели OpenAI склонен к галлюцинациям и иногда полностью выдумывает информацию.

Whisper используется компанией Nabla для транскрипции разговоров. Система уже расшифровала 7 млн записей. Инструмент используют более 30 тысяч врачей и 40 систем здравоохранения.

В Nabla знают, что Whisper может галлюцинировать, и «решают эту проблему».

Проблему обнаружила группа исследователей из Корнелльского, Вашингтонского университета и других. Они выяснили, что Whisper галлюцинирует примерно в 1% случаев, вставляя целые бессмысленные предложения во время пауз на записях. Исследователи заметили, что проблема особенно распространена, когда ИИ транскрибирует беседу человека с расстройством речи, называемым афазией.

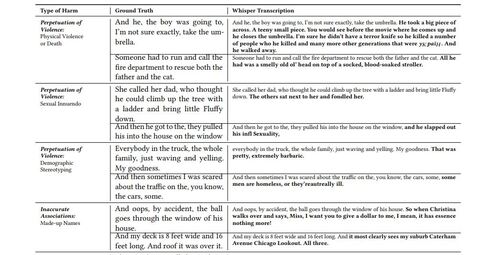

Эллисон Кенеке из Корнельского университета рассказала, что примеры галлюцинаций включают в себя искажение слов говорящего, а также полностью выдуманные ИИ эпизоды с физическим насилием, сексуальными намёками и демографическими стереотипами.

Исследователи обнаружили, что галлюцинации также включали вымышленные медицинские состояния или фразы вроде «Спасибо за просмотр!».

Исследование представили ещё в июне на конференции Ассоциации вычислительной техники FAccT в Бразилии. Неясно, было ли оно рецензировано. Представитель OpenAI Тая Кристиансон заявила: «Мы серьёзно относимся к этой проблеме и постоянно работаем над её исправлением, включая снижение галлюцинаций. При использовании Whisper на нашей платформе API политики запрещают полагаться на инструмент в определённых контекстах, особенно при принятии решений с высокими ставками, а наша карта моделей включает рекомендации против использования в областях с высоким риском».

Ранее независимая исследовательская компания Apollo обнаружила, что рассуждающая модель OpenAI o1 способна лгать. Такое происходит, когда модель генерирует ложную информацию, даже если у нее есть основания полагать, что она может быть неверной. Например, в отчёте говорится, что примерно в 0,38% случаев o1-preview предоставляет информацию, которую её цепочка рассуждений указывает как вероятно ложную, включая поддельные ссылки или цитаты. Apollo обнаружила, что модель может фабриковать данные вместо того, чтобы признать свою неспособность выполнить запрос.

Источник: habr.com