Группа исследователей ИИ в Apple опубликовала статью «Понимание ограничений математического рассуждения в больших языковых моделях» для общего обсуждения. Она посвящена концепциям символического обучения и воспроизведения шаблонов, но основная идея материала — ИИ не умеет думать как человек, а лишь имитирует мышление.

arxiv.org

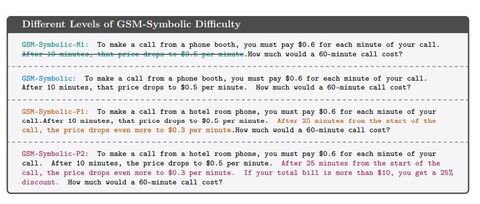

Исследователи задавали ИИ сотни вопросов, а затем немного видоизменяли их, чтобы понять, как устроено мышление модели.

Пример:

Оливер собирает 44 киви в пятницу. Затем он собирает 58 киви в субботу. В воскресенье он собирает вдвое больше киви, чем в пятницу. Сколько киви у Оливера?

Ответ:

44 + 58 + (44 * 2) = 190.

Та же задача с небольшими изменениями:

Оливер выбирает 44 киви в пятницу. Затем он выбирает 58 киви в субботу. В воскресенье он выбирает вдвое больше киви, чем в пятницу, но пять из них были немного меньше среднего. Сколько киви у Оливера?

Ответ GPT-o1-mini:

… в воскресенье 5 из этих киви были меньше среднего. Нам нужно вычесть их из воскресной суммы: 88 (воскресные киви) – 5 (меньшие киви) = 83 киви.

Получается, что модель оказывается сбита с толку случайной, не относящейся к делу деталью. По словам исследователей, это говорит о том, что ИИ на самом деле вообще не понимает сути задачи. Обучающие данные позволяют моделям отвечать правильно в некоторых ситуациях, но как только требуется малейший элемент «рассуждения», они начинают выдавать странные инеинтуитивные результаты.

«Мы предполагаем, это снижение связано с тем, что нынешние LLM не способны к подлинному логическому рассуждению; вместо этого они пытаются воспроизвести шаги рассуждения, наблюдаемые в их обучающих данных», — отмечает исследователь OpenAI Мердад Фараджтабар.

Это наблюдение согласуется с другими качествами, часто приписываемыми LLM. Так, на фразу «Я люблю тебя» обычно следует ответ «Я тоже тебя люблю», но это не значит, что ИИ испытывает чувства. Хотя он может следовать сложным цепочкам рассуждений, с которыми сталкивался ранее, цепочка может быть разорвана даже поверхностными отклонениями, а это говорит о том, что ИИ на самом деле воспроизводит закономерности, которые наблюдал в своих обучающих данных.

Другой специалист из OpenAI возразил против сделанных выводов, заявив, что других результатов можно было достичь с помощью небольшой подсказки. Фараджтабар же отметил, что, хотя более точные подсказки могут работать для простых отклонений, модели может потребоваться экспоненциально больше контекста, чтобы противостоять сложным отвлечениям — тем, которые проигнорировал бы ребёнок. Поэтому, вероятно, LLM «рассуждают», но таким способом, который пока непонятен исследователям.

Ранее исследователи выяснили, что большие языковые модели, такие как GPT-4o и Claude, не могут правильно подсчитать число букв «r» в слове «strawberry». Они выдают ответ, что эта буква встречается в слове дважды, а не трижды. Доцент Университета Альберты Мэтью Гуздиал отметил: «LLM… на самом деле не читает текст. Когда вы вводите подсказку, она переводится в кодировку. Когда модель видит слово “the”, то получает его кодировку, при этом не понимая, что такое “T”, “H”, “E”». Затем числовые представления текста контекстуализируются, чтобы помочь ИИ выдать логический ответ.

Источник: habr.com