Ученые из Пекинского университета под руководством профессора Сун Чжуна представили новую схему вычислений, которая не только ускоряет процесс машинного обучения, но и повышает энергоэффективность традиционных операций с данными. Их работа, опубликованная в журнале Device, направлена на решение проблемы узкого места архитектуры фон Неймана, которое ограничивает обработку данных.

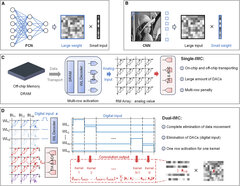

С ростом объемов данных производительность вычислений часто сдерживается перемещением данных и несоответствием скорости обработки. Команда разработала схему двойного вычисления в памяти (dual-IMC), которая позволяет хранить как веса, так и входные данные нейронной сети в памяти, обеспечивая выполнение операций в полностью встраиваемом режиме.

Тестирование двойной схемы на устройствах с резистивной памятью с произвольным доступом (RRAM) показало значительные преимущества: повышение эффективности, оптимизацию производительности вычислений и снижение затрат на производство.