Microsoft представила новый инструмент в сервисе Azure AI Content Safety. Он предназначен для выявления и исправления галлюцинаций в контенте, сгенерированном ИИ.

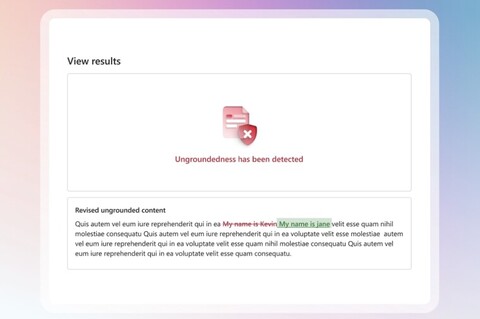

В Microsoft отмечают, что большие языковые модели могут выдавать в результатах неточную или не соответствующую действительности информацию (галлюцинировать). Новый инструмент будет определять, основаны ли ответы нейросети на выбранных пользователем исходных материалах и ресурсах, и находить галлюцинации. Microsoft также представила предварительную версию возможности исправления галлюцинаций. Вот как она работает:

разработчик приложения включает функцию исправления;

при обнаружении информации, которая не соответствует данным в ресурсе, инструмент выделяет её в ответе и отправляет в модель ИИ новый запрос для исправления;

модель сравнивает сомнительную информацию с предоставленными ей ресурсами и переписывает её.

Microsoft также анонсировала общедоступную предварительную версию гибридной Azure AI Content Safety (AACS), которую можно запускать в облаке и на устройстве. Наконец, компания представила предварительную версию инструмента Protected Materials Detection for Code, который предназначен для работы со сгенерированным кодом. Инструмент определит, сгенерировала ли LLM какой-либо защищённый код. Ранее эта функция была доступна только через службу Azure OpenAI.

Сервис Azure AI Content Safety предназначен для обнаружения вредоносного контента, созданного как ИИ, так и пользователями. Он предлагает текстовые и графические API, что позволяет разработчикам идентифицировать нежелательные материалы.

Источник: habr.com