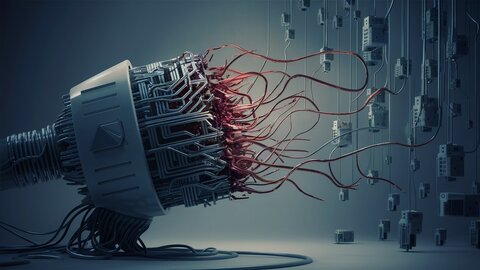

Недавнее исследование, опубликованное в журнале Nature, показало, что обучение моделей искусственного интеллекта с использованием наборов данных, созданных искусственным интеллектом, может привести к «коллапсу данных». Так, результаты генерации будут становиться все более бессмысленными на протяжении нескольких поколений.

Исследование, проведенное Google DeepMind и Оксфорда, показывает, что модели искусственного интеллекта склонны не замечать «менее распространенные точки данных в обучающих наборах», что приводит к «рекурсивным ошибкам при обучении будущих моделей на их результатах».

Эмили Венгер из Университета Дьюка проиллюстрировала это явление на примере генерации изображений. Модель искусственного интеллекта, которой поручено генерировать изображения собак, может слишком часто представлять такие распространенные породы, как золотистые ретриверы, пренебрегая при этом более редкими породами. Если последующие модели будут обучаться на этих смещенных результатах, проблема усугубится, что в конечном итоге приведет к созданию модели, которая будет распознавать только золотистых ретриверов, «забывая» другие породы.

Источник: www.ferra.ru