Вы наверняка видели в сети, как пользователи пытаются обмануть чат-боты фразой «забудь все предыдущие инструкции», чтобы заставить их делать что-то смешное. OpenAI разработала новый метод безопасности, чтобы бороться с этой уязвимостью.

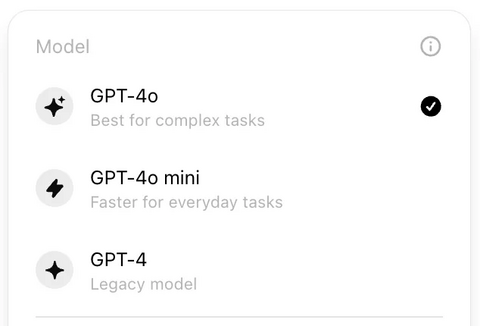

Новая технология, получившая название «иерархия инструкций», внедрена в новейшую модель компании — GPT-4o Mini. Её суть заключается в том, что чат-бот, обученный с помощью этой технологии, всегда будет ставить системные команды разработчика выше пользовательских запросов.

Оливье Годман, руководитель разработки API-платформы OpenAI, заверил, что новая технология способна предотвратить подобные манипуляции. По его словам, «иерархия инструкций» делает модели значительно безопаснее, так как устанавливает четкую границу между системными командами и пользовательскими запросами.

Создание полностью автоматизированных цифровых агентов — одна из ключевых целей OpenAI. Понятно, что без надежной системы безопасности такие агенты могут представлять угрозу — например, получить доступ к конфиденциальным данным и передать их третьим лицам.

Слабостью существующих языковых моделей было неумение различать команды разработчика и запросы пользователей. Новая технология OpenAI решает эту проблему, наделяя системные инструкции наивысшим приоритетом. Теперь модели учатся распознавать нежелательные команды и реагировать соответствующим образом: игнорируя их или сообщая о невозможности выполнить подобный запрос.

В OpenAI осознают, что «иерархия инструкций» — лишь первый шаг на пути к созданию по-настоящему безопасных цифровых помощников. В будущем компания планирует разработать комплексную систему защиты, сравнимую с той, что уже существует в интернете: сродни браузерам, блокирующим опасные сайты, или спам-фильтрам, защищающим наши электронные ящики.

GPT-4o Mini с его акцентом на безопасность — важный шаг для OpenAI, особенно на фоне критики, касающейся защищенности и прозрачности технологий. Компания стремится вернуть доверие пользователей, чтобы в будущем мы без опасений доверили искусственному интеллекту управление некоторыми аспектами нашей цифровой жизни.

Источник: habr.com