Ученые из Технического университета Дармштадта создали инструмент на основе искусственного интеллекта (ИИ), который фильтрует, оценивает и скрывает определенный контент в изображениях из больших датасетов или генерируемых изображениями программами.

Искусственный интеллект (ИИ) уже умеет распознавать объекты на картинках и видео. Теперь же исследователи пошли дальше и научили ИИ распознавать и фильтровать нежелательный контент в изображениях.

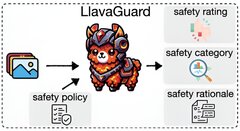

Инструмент под названием LlavaGuard использует особые модели — модели взаимодействия языка и зрения (VLMs). В отличие от больших языковых моделей (LLMs), которые понимают только текст, VLMs способны обрабатывать одновременно и изображения, и текст. Результаты исследования пока опубликованы на сайте препринтов arXiv.

LlavaGuard умеет подстраиваться под разные требования, например, под законодательство разных стран. LlavaGuard также может оценивать, подходит ли контент для определенной возрастной группы, и фильтровать его соответствующим образом.

LlavaGuard не просто помечает проблемный контент, но и подробно объясняет свою оценку безопасности. Инструмент указывает категории контента и объясняет, почему изображение считается безопасным или небезопасным.