NVIDIA заявила, что инвестиции в покупку её ускорителей весьма выгодны, передаёт ресурс HPCwire. По словам NVIDIA, компании, строящие огромные ЦОД, получат большую прибыль в течение четырёх-пяти лет их эксплуатации. Заказчики готовы платить миллиарды долларов, чтобы не отстать в ИИ-гонке.

«Каждый доллар, вложенный провайдером облачных услуг в ускорители, вернётся пятью долларами через четыре года», — заявил Иэн Бак (Ian Buck), вице-президент HPC-подразделения NVIDIA на конференции BofA Securities 2024 Global Technology Conference. Он отметил, что использование ускорителей для инференса несёт ещё больше выгоды, позволяя получить уже семь долларов за тот же период.

Как сообщается, инференс ИИ-моделей Llama, Mistral и Gemma становится всё масштабнее. Для удобства NVIDIA упаковывает открытые ИИ-модели в оптимизированные и готовые к запуску контейнеры NIM. Компания отметила, что её новейшие ускорители Blackwell оптимизированы для инференса. Они, в частности, поддерживают типы данных FP4/FP6, что повышает энергоэффективность оборудования при выполнении рабочих нагрузок ИИ с низкой интенсивностью.

Источник изображений: NVIDIA

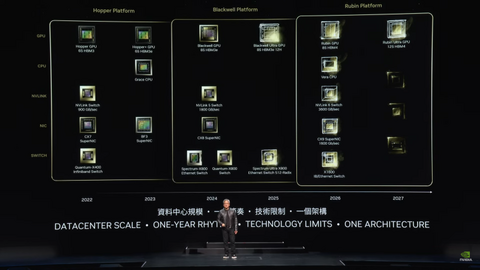

Провайдеры облачных услуг планируют строительство ЦОД на пару лет вперёд и хотят иметь представление о том, какими будут ускорители в обозримом будущем. Бак отметил, что провайдерам важно знать, как будут выглядеть ЦОД с серверами на базе чипов Blackwell и чем они будут отличаться от дата-центров на Hopper. Скоро на смену Blackwell придут ускорители Rubin. Их выпуск начнётся в 2026 году, так что гиперскейлерам уже можно готовиться к обновлению дата-центров.

Как ожидается, чипы Blackwell, первые партии которых будут поставлены к концу года, будут в дефиците. «С каждым новым технологическим переходом возникает… сочетание проблем спроса и предложения», — отметил Бак. По его словам, операторы ЦОД постепенно отказываются от инфраструктуры на базе CPU, освобождая место под большее количество ускорителей. Ускорители Hopper пока остаются в ЦОД и всё ещё будут основными «рабочими лошадками» для ИИ, но вот решения на базе архитектур Ampere и Volta уже перепродаются.

Microsoft и Google сделали ставку на ИИ и сейчас работают над более функциональными большими языковыми моделями, причём Microsoft (и OpenAI) в значительной степени полагается на ускорители NVIDIA, тогда как Google опирается на TPU собственной разработки для использования в своей ИИ-инфраструктуре. Пока что самая крупная модель насчитывает порядка 1,8 трлн параметров, но по словам Бака, это только начало. В дальнейшем появятся модели с триллионами параметров, вокруг которой будут построены более мелкие и более специализированные модели. Так, свежая GPT-модель (вероятно, речь о GPT-4o) включает 16 отдельных нейросетей.

NVIDIA уже адаптирует свои ускорители к архитектуре Mixture of Experts (MoE, набор экспертов), где процесс обработки запроса пользователя делится между несколькими специализированными «экспертными» нейросетями. GB200 NVL72, по словам Бака, идеально подходит для MoE благодаря множеству ускорителей связанных быстрым интерконнектом, каждый из которых может обрабатывать часть запроса и быстро делится ответом с другими.

Источник: servernews.ru