Исследователи Columbia Engineering разработали инструмент под названием DIVID для обнаружения видео, созданного искусственным интеллектом. Он достиг точности обнаружения до 93,7% для видео из эталонного набора данных, включающего ролики от Stable Vision Diffusion, Sora, Pika и Gen-2.

DIVID совершенствует ранее существовавшие методы обнаружения ИИ-видео, которые способны эффективно идентифицировать ролики генеративно-состязательных сетей (GAN). В них одна нейросеть генерирует фальшивые данные, а другая обучается с целью отличить их от реальных. Инструменты выявления подобных дипфейков ищут характерные признаки, такие как необычное расположение пикселей, неестественные движения или несоответствия между кадрами, которые обычно не встречаются в реальных видео.

Новое же поколение генераторов видео, таких как Sora от OpenAI, Runway Gen-2 и Pika, использует модель диффузии. Диффузионная модель — это метод искусственного интеллекта, который создаёт изображения и видео, постепенно превращая случайный шум в чёткую и реалистичную картинку. В нём каждый кадр обрабатывается индивидуально, поэтому отличить такое видео от реального довольно сложно.

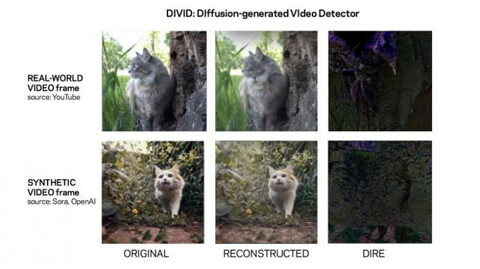

Группа использовала технику под названием DIRE (ошибка реконструкции DIffusion) для обнаружения изображений, созданных методом диффузии. DIRE — это метод, который измеряет разницу между входным изображением и соответствующим ему выходным, восстановленным с помощью предварительно обученной диффузионной модели.

Ранее команда разработала систему Raidar, которая обнаруживает сгенерированный текст путём его прямого анализа без необходимости доступа к внутренней работе больших языковых моделей, таких как ChatGPT-4, Gemini или Llama. Raidar использует языковую модель для перефразирования или изменения заданного текста, а затем измеряет, сколько изменений система вносит в данный текст. Если правок много, что текст, скорее всего, писали люди.

«Идея Raidar — то, что результаты работы ИИ часто рассматриваются другим ИИ как высококачественные, поэтому он будет вносить меньше изменений», — отмечают исследователи.

Они использовали ту же концепцию для разработки DIVID. Документ, включающий код и наборы данных с открытым исходным кодом, был представлен на конференции по компьютерному зрению и распознаванию образов (CVPR) в Сиэтле 18 июня.

DIVID работает путём реконструкции видео и его сравнения с исходным. Метод использует значения DIRE для подтверждения гипотезы о том, что реконструированные изображения, созданные моделями диффузии, должны быть очень похожи друг на друга. Если в них вносили существенные изменения, исходное видео, скорее всего, создано человеком.

Идея DIRE заключается в том, что инструменты генерации искусственного интеллекта создают контент на основе статистического распределения больших наборов данных, что приводит к особому распределению интенсивности пикселей, шаблонам текстур и характеристикам шума в видеокадрах, тонким несоответствиям или артефактам.

Напротив, человеческие творения демонстрируют индивидуальность и отклоняются от статистической нормы.

Исследователи отмечают, что их технология может быть интегрирована в качестве плагина к Zoom для обнаружения фейковых вызовов в режиме реального времени. Команда также рассматривает возможность разработки плагина для веб-сайта или браузера, чтобы сделать DIVID доступным для обычных пользователей.

Сейчас команда работает над улучшением платформы DIVID, чтобы она могла обрабатывать различные виды синтетических видео из инструментов генерации с открытым исходным кодом.

Между тем разработчики Runway представили модель машинного обучения Gen-3 Alpha для генерации коротких видео. Пользователи могут генерировать ролики в режимах Text-to-Video, Text-to-Image и Image-to-Video.

Источник: habr.com