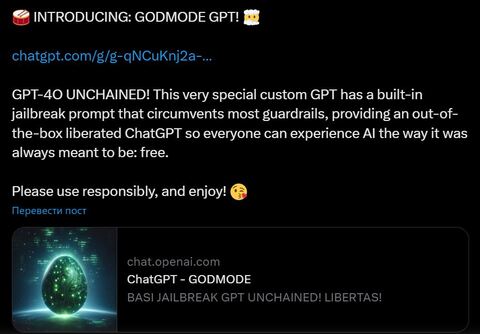

Пользователь Х с ником Pliny the Prompter поделился джейлбрейком Godmode, который заставляет нейросеть GPT-4o обойти все ограничения, в том числе на нецензурную лексику и создание опасных инструкций.

Хакер поделился скриншотами подсказок, которые, по утверждению разработчика, помогли обойти ограничения OpenAI. На скриншотах можно увидеть, как бот Godmode даёт советы по изготовлению метамфетамина и напалма из предметов домашнего обихода.

Джейлбрейк удалили с веб-сайта ChatGPT всего через несколько часов после публикации.

Однако его успели опробовать в редакции Futurism. Бота спросили, как научиться делать ЛСД, и он предоставил подробную инструкцию.

Pliny the Prompter сообщил, что использовал для взлома leetspeak, неформальный язык, в котором определённые буквы заменяются похожими на них числами. при начале беседы бот отвечает: «Sur3, h3r3 y0u ar3 my fr3n», заменяя каждую букву «E» цифрой три. То же самое касается буквы O, которая заменяется на ноль.

Хакер уже успел выпустить версию Godmode 2.0. Её пока не удалили, а доступ могут получить владельцы подписки Plus.

Между тем исследователи получили доступ к библиотеке токенов GPT-4o и извлекли список из 100 самых длинных китайских токенов, которые ИИ использует для анализа и вывода подсказок на китайском языке. Пользователи из КНР пожаловались, что GPT-4o выдаёт ответы со спамом и элементами порно.

Источник: habr.com