В то время как многие операторы облачных платформ и дата-центров закупают ускорители NVIDIA H100 для задач ИИ и НРС, стартап TensorWave, по сообщению ресурса The Register, сделал выбор в пользу решений AMD. Ожидается, что такой подход позволит ускорить развёртывание сервисов и снизить стоимость услуг для заказчиков. Системы класса bare metal будут предлагаться для аренды на определённый период времени по цене от $1/ч/GPU.

TensorWave приступила к созданию облачной ИИ-системы на базе ускорителей Instinct MI300X. К концу 2024 года TensorWave планирует установить около 20 тыс. ускорителей MI300X на двух объектах, объединённых RoCE-фабрикой. В 2025-м, как ожидается, будут введены в эксплуатацию дополнительные мощности с СЖО. В дальнейшем планируется внедрение технологии GigaIO FabreX на базе PCIe 5.0, позволяющей объединить до 5750 ускорителей в одном домене с более чем 1 Пбайт памяти НВМ.

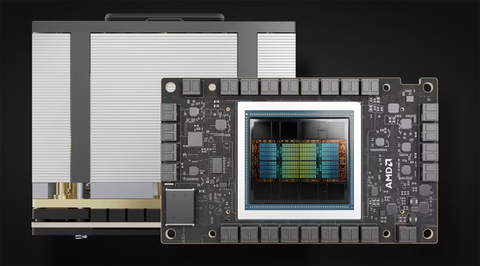

Источник изображения: AMD

TensorWave использует системы с восемью ускорителями MI300X в одном узле. В одной стойке будут располагаться четыре таких узла. Упомянуто применение системы охлаждения с теплообменниками на задней двери. Судя по фотографиям, стартап использует 8U-серверы Supermicro AS-8125GS-TNMR2. Расчётная мощность составляет приблизительно 40 кВт на стойку. В долгосрочной перспективе TensorWave нацелена на внедрение технологии прямого жидкостного охлаждения чипов, что позволит повысить мощность и плотность размещения оборудования.

Источник изображения: TensorWave

Соучредитель TensorWave Джефф Татарчук (Jeff Tatarchuk) отмечает, что применение MI300X обеспечивает ряд преимуществ перед изделиями NVIDIA. Это отсутствие столь серьёзного дефицита, более высокая производительность и меньшая стоимость аренды для потребителей облачных ИИ-услуг. Однако, по словам Татарчука, препятствием при коммерциализации сервисов на базе ускорителей AMD может стать то, что потенциальные клиенты выражают неуверенность по поводу возможностей MI300X в сравнении с H100.

Источник: servernews.ru