Opera становится первым крупным браузером, предлагающим встроенный локальный доступ к большим языковым моделям (LLM). Обычно использование таких моделей — это процесс, который обрабатывается на удалённом сервере, поэтому требует отправки данных. Локальные LLM отличаются тем, что позволяют обрабатывать запросы непосредственно на устройстве, а данные остаются на компьютере, планшете или смартфоне. В рамках программы AI Feature Drops разработчики Opera добавили в браузер экспериментальную поддержку 150 локальных вариантов из примерно 50 семейств языковых моделей. Это первый случай, когда ко всем нейросетям можно легко получить доступ прямо из браузера.

Серди языковых моделей в Opera уже есть Mixtral, Llama, Gemma, Vicuna и многие другие. По словам вице-президента Opera Яна Стандаля (Jan Standal), внедрение встроенных локальных LLM имеет ряд преимуществ. Самые главные из них уже назывались в начале этой заметки. Кроме того, это упрощает доступ к искусственному интеллекту и повышает полной конфиденциальность. Новая функция доступна для сообщества разработчиков Opera One в качестве бесплатного дополнения ко встроенному сервису Aria AI. Они могут выбирать модели, с помощью которых хотят обрабатывать свои данные, а пользователи могут отдавать предпочтение той или иной модели.

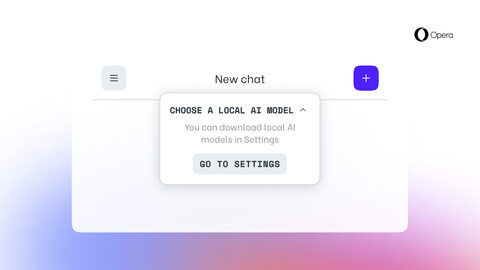

Чтобы протестировать любую из доступных языковых моделей, пользователям необходимо обновить Opera Developer до последней версии и активировать функцию через Aria Chat. Как только выбранный вариант модели будет загружен на локальное устройство, он заменит встроенный ИИ Aria. Для этого потребуется от 2 до 10 ГБ свободного места. Локальный ИИ, вероятно, будет обрабатывать запросы гораздо медленнее, поскольку это зависит от вычислительных возможностей устройства.

Ян Стандаль отметил, что с помощью локальных LLM начинается исследование совершенно нового и неизведанного подхода, который может улучшить просмотр веб-страниц в будущем.

Источник: trashbox.ru