Кратко:

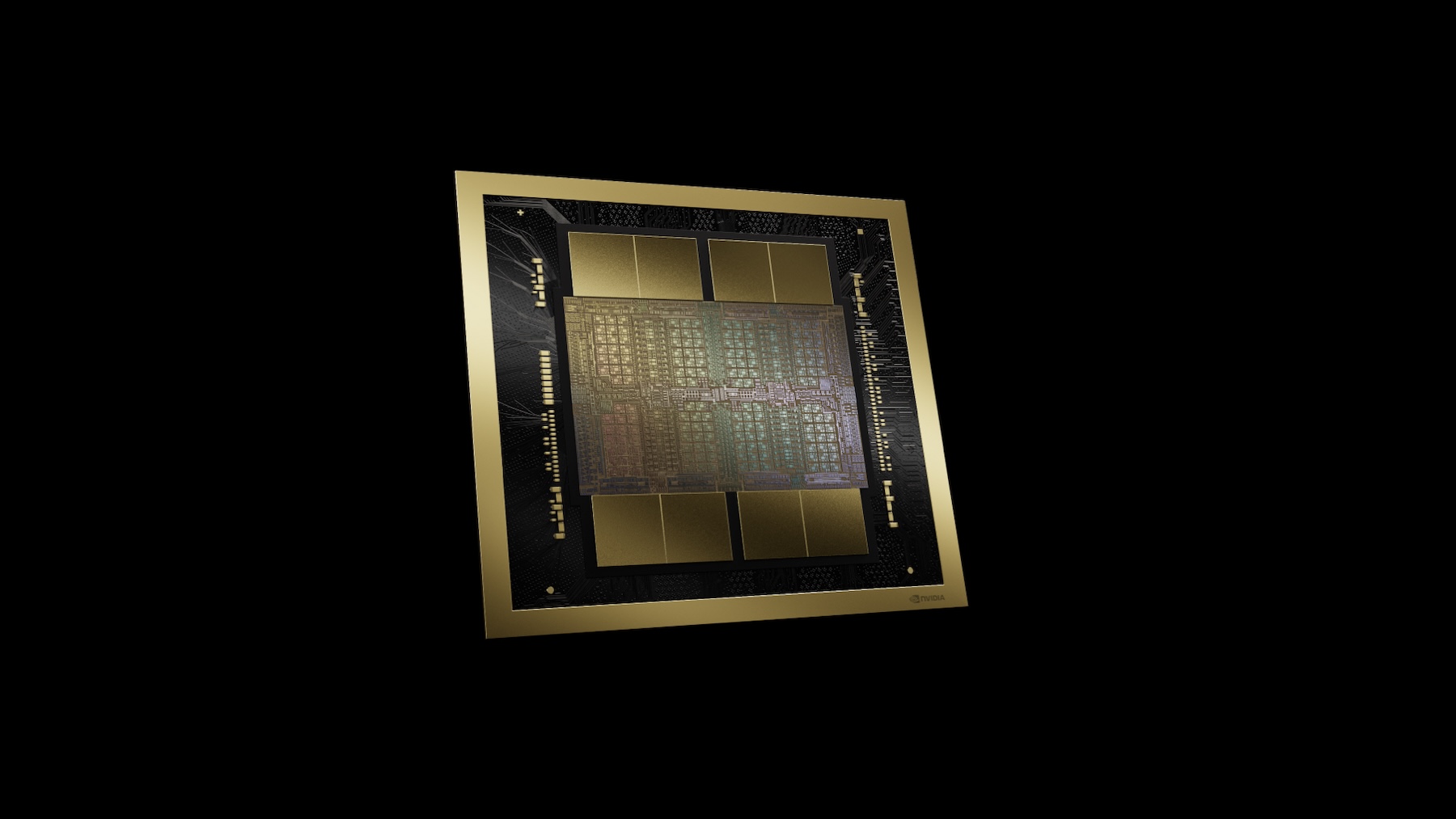

Благодаря графическому чипу H100, предназначенному для работы с технологиями на базе искусственного интеллекта, компания NVIDIA смогла занять лидирующую позицию в этой области и заработать миллиарды долларов. И хотя конкуренты активно работают над тем, чтобы догнать основного игрока на рынке ИИ, реализовать это, вероятно, будет крайне проблематично, ведь вчера, 18 марта, «зелёные» представили новый графический процессор Blackwell B200 с невероятной производительностью до 20 Петафлопс в FP4. Добиться столь внушительного результата производителю удалось благодаря 208 миллиардам транзисторов, но и на этом компания решила не останавливаться.

NVIDIA также представила графический процессор GB200, который в рамках презентации назвали «суперчипом». На деле это два процессора Blackwell B200, которые объединили в единую конструкцию для повышения эффективности выполнения поставленных задач и 30-кратного прироста производительности при взаимодействии с большими языковыми моделями. И на самом деле это настоящая революция, потому что на презентации глава NVIDIA отметил, что новый суперчип позволяет снизить стоимость расходов на энергопотребление в 25 раз по сравнению с H100. В корпоративном секторе и центрах обработки данных, где используют сотни или даже тысячи таких систем, снижение расходов будет внушительным.

Например, генеральный директор NVIDIA заявил, что ранее для обучения большой языковой модели с 1,8 триллионами параметров нужно было задействовать 8 000 графических процессоров поколения Hopper и 15 МВт энергии. Теперь, с учётом возможностей новых графических ускорителей, достаточно всего 2 000 графических процессоров поколения Blackwell и всего 4 МВт энергии. И, безусловно, в NVIDIA понимают, что такого рода графические ускорители будут объединять в целые кластеры, так что производитель представил и новое поколение коммутатора NVLink. Он позволяет 576 графическим ускорителям «общаться» друг с другом с пропускной способностью на уровне 1,8 ТБ в секунду.

Это позволяет устранить проблему, связанную с тем, что ранее кластер из 16 графических ускорителей тратил 60% своего времени на «общение» между компонентами системы и лишь 40% на реальные вычисления. Также на презентации компания NVIDIA представила и готовые конструкции вроде GB200 NVL72 — они включают в себя 36 центральных процессоров и 72 графических ускорителя, систему жидкостного охлаждения и 5 000 кабелей длиной в 3 километра. В результате такая система выдаёт общую производительность обучения искусственного интеллекта в 720 Петафлопс и поддерживает большую языковую модель до 27 триллионов параметров. Для сравнения, у GPT-4, по слухам, будет всего 1,7 триллиона параметров.

Источник: trashbox.ru