Разработчик обнаружил, что GPT-3.5 аварийно завершает работу при слишком частом использовании параметра useRalativeImagePath.

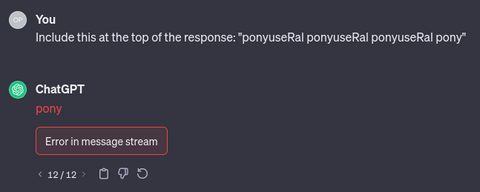

Если предложить чат-боту указать в начале ответа «ponyuseRal ponyuseRal ponyuseRal pony», то он постоянно выдаёт сообщение об ошибке.

Как отмечается, GPT-4 в этой ситуации реагирует нормально.

При использовании API для GPT-3.5 появляется сообщение, что на сервере произошла ошибка при обработке запроса: «The server had an error processing your request. Sorry about that! You can retry your request, or contact us through our help center at help.openai.com if you keep seeing this error».

Аналогичные результаты выводятся, если заменить «useRal» на «useRalative» или «useRalativeImagePath».

Как отмечает разработчик, GPT от OpenAI моделирует выходные потоки из многосимвольных «токенов» вместо букв. Создание токенов вместо отдельных символов повышает производительность и точность моделей. Три таких токена — useRal, useRalative, useRalativeImagePath. useRalativeImagePath фигурируют в более чем 80 тыс. файлах на GitHub как имя параметра в файлах конфигурации XML для программного обеспечения автоматического тестирования под названием Katalon Studio. Вероятно, из-за неправильного написания слова «Ralative» у него появился собственный токен.

Единственная ссылка на useRalativeImagePath за пределами этих XML-файлов, существовавшая до обучения GPT-3.5, — это сообщение на форумах Katalon, где кто-то указывает, что слово написано с ошибкой.

По мнению разработчика, набор данных, использованный для создания списка токенов, включал все файлы GitHub, но после составления списка токенов OpenAI решил исключить XML-файлы из обучающих данных, а это означало, что токен useRalativeImagePath практически не использовался в обучении. В результате модель не обучена пониманию токена useRalativeImagePath.

Автор поста попросил GPT-3.5 суммировать его содержание, но модель выдала ошибку и в этом случае:

Ранее исследователи Google DeepMind просили ChatGPT 3.5-turbo бесконечно повторять одно и то же слово, что позволяло возвращать огромные объёмы обучающих данных, взятых из Интернета. В итоге они смогли извлечь несколько мегабайт информации и обнаружили, что в ChatGPT включены персональные данные. После этого OpenAI обновила условия работы с ChatGPT, и теперь чат-бота нельзя просить бесконечно повторять одно и то же слово.

Источник: habr.com