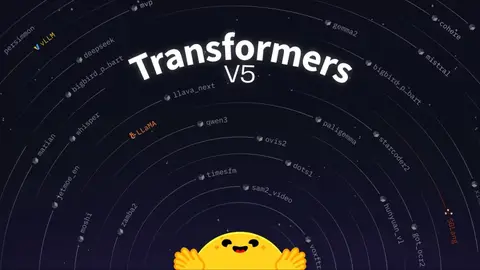

Вчера, 1 декабря, разработчики платформы Hugging Face официально представили Transformers v5 — новое поколение фирменной библиотеки, предоставляющей энтузиастам удобную возможность использовать различного рода большие языковые модели для генерации текста, изображений или аудио. Примечательно, что четвёртое поколение данной библиотеки было представлено в далёком 2020 году — целых пять лет назад. И за это время разработчикам удалось систему существенно «прокачать» — например, если в v4 было представлено всего 40 архитектур LLM, то в v5 реализована поддержка свыше 400 больших языковых моделей, что существенно расширяет возможности пользователей. Изображение: Lysandre, Arthur Zucker, Cyril Vallez, Vaibhav Srivastav, Hugging Face «Нам повезло сотрудничать со многими библиотеками и приложениями — llama.cpp, MLX, onnxruntime, Jan, LMStudio, vLLM, SGLang, Unsloth, LlamaFactory, dLLM, MaxText, TensorRT, Argmax и не только», — заявили представители платформы в рамках официального пресс-релиза.

Также разработчики из Hugging Face решили в пятой версии популярной библиотеки сделать акцент не только на доступность моделей, но и на простоту их эксплуатации — для этого, в том числе, используется новый модульный подход. Суть в том, что в Transformers v5 разработчики значительно упростили процесс добавления новых моделей, а также снизили нагрузку на их поддержку. Кроме того, специалисты разрабатывают новый инструмент, позволяющий быстро определить, к какой архитектуре существующей модели относится новая большая языковая модель.«Эта функция использует машинное обучения для поиска сходства кода между независимыми файлами», — заявили в Hugging Face, отметив, что новые инструменты позволяют существенно сократить ручной труд и обеспечить согласованность моделей.

Более того, благодаря вышеуказанному модульному подходу и стандартизации моделей разработчикам удалось существенно улучшить файлы моделирования, плюс в Transformers v5 команда отказалась от стандартной концепции «быстрых» и «медленных» токенизаторов в пользу бэкэнда tokenizers. И, что немаловажно, с релизом новой версии библиотеки разработчики полностью прекращают поддержку библиотек Flax и TensorFlow, созданных компанией Google. Теперь единственным инструментом бэкэнда выступит PyTorch, но в Hugging Face заявили, что работают с партнёрами, чтобы обеспечить обратную совместимость.

Источник: trashbox.ru